3. Breve Introdução à Detecção Remota¶

3.1. Definições Básicas¶

This chapter provides basic definitions about GIS and remote sensing. For other useful resources see Free and valuable resources about remote sensing and GIS.

3.1.1. Definição de SIG¶

Existem diversas definições para SIG (Sistemas de Informação Geográfica), que não são simplesmente pacotes de software. Em geral, os SIG são sistemas que permitem trabalhar com dados geográficos (dados aos quais se encontram associadas coordenadas espaciais). Numa perspetiva mais detalhada, os SIG permitem a visualização, consulta, cálculo e análise de dados espaciais, que se podem, genericamente, dividir em estruturas de dados vectoriais e raster. Os vectores podem ser constituídos por pontos, linhas ou polígonos, e cada objeto num vector pode ter um, ou mais, atributos alfanuméricos associados. Os rasters são grelhas (ou imagens) onde cada pixel/célula tem um determinado valor associado (Fisher and Unwin, 2005). Diversos softwares SIG usam imagens raster que provêm da Detecção Remota.

3.1.2. Definição de Detecção Remota¶

Uma definição geral de Detecção Remota é a que refere que se trata “da ciência e tecnologia através da qual as características dos objectos de interesse podem ser identificadas, medidas ou analisadas sem existir contacto directo com os mesmos” (JARS, 1993).

Normalmente, a Detecção Remota corresponde à medição da energia que é emanada a partir da superfície da Terra. Se a fonte da energia medida é o Sol, então pode classificar-se como Detecção Remota passiva, e o resultado dessa medição pode ser uma imagem digital (Richards and Jia, 2006). Se a energia medida não é emitida pelo Sol, mas sim pela própria plataforma orbital, então define-se como Detecção Remota activa, como é o caso dos sensores RADAR, que funcionam na banda das microondas (Richards and Jia, 2006).

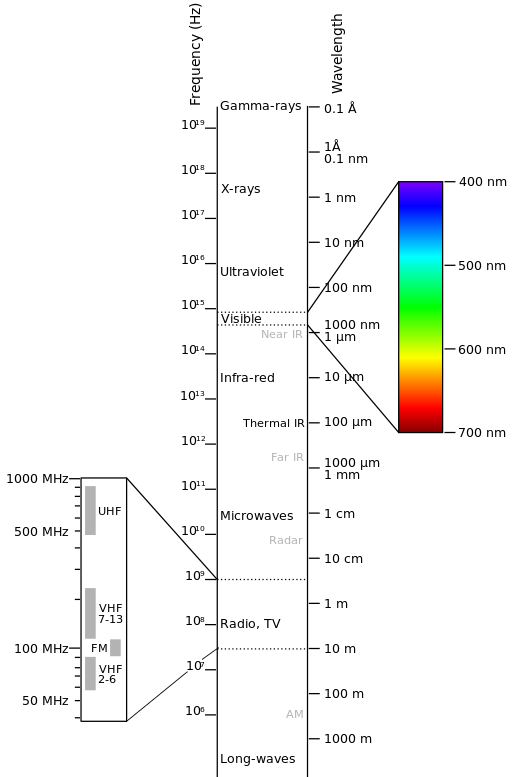

O espectro electromagnético é “o sistema que classifica, de acordo com o comprimento de onda, toda a energia (desde os raios gama, de comprimento de onda curto, até às ondas rádio, de comprimento de onda muito longo) que se move, harmonicamente, à velocidade da luz” (NASA, 2013). Os sensores passivos medem a energia das regiões ópticas do espectro electromagnético: visível, infravermelho próximo (NIR), infravermelho médio e infravermelho térmico (see Figure Espectro Electromagnético).

Espectro Electromagnético

criado por Victor Blacus (versão SVG do ficheiro: Electromagnetic-Spectrum.png)`

[CC-BY-SA-3.0 (http://creativecommons.org/licenses/by-sa/3.0)]

via Wikimedia Commons

http://commons.wikimedia.org/wiki/File%3AElectromagnetic-Spectrum.svg

A interacção entre a energia solar e os materiais depende do comprimento de onda; a energia solar viaja do Sol até à superfície da Terra e a partir daí retorna até ao sensor. Neste percurso, a energia solar é (NASA, 2013):

Transmitida - A energia passa através de uma alteração na velocidade, conforme determinado pelo índice de refracção para os dois meios em questão.

Absorvida - A energia é perdida para o objecto através de reacções electrónicas ou moleculares.

Reflectida - A energia inalterada é reenviada para o espaço com o ângulo de incidência igual ao ângulo de reflexão. A reflectância de um corpo corresponde à razão entre a radiação refletida e a radiação incidente. O comprimento de onda reflectido (não absorvido) determina a cor do objecto.

Dispersada - A direcção de propagação da energia é alterada aleatoriamente. Dispersão de Rayleigh e de Mie são os dois principais tipos de dispersão atmosférica.

Emitida - Na realidade, a energia é inicialmente absorvida e depois reemitida, normalmente com um comprimento de onda maior. O objecto é aquecido por intermédio deste fenómeno.

3.1.3. Sensores¶

Os sensores podem ser transportados a bordo de aviões ou a bordo de satélites artificiais, fazendo a medição da radiação electromagnética em intervalos específicos (normalmente designados por bandas). Como resultado, as medições são quantificadas e convertidas em imagens digitais, onde cada elemento da imagem (pixel) tem um valor discreto, designado valor digital (DN - “Digital Number”) (NASA, 2013), e que corresponde à intensidade de energia electromagnética reflectida pela área do terreno correspondente ao pixel considerado. As imagens resultantes têm características diferentes (resoluções) dependendo do sensor com que se vai trabalhar. Assim, existem vários tipos de resoluções:

A resolução espacial, normalmente traduzida pelo comprimento do lado de uma parcela de terreno que, no nadir, corresponde a um pixel na imagem, “é a capacidade de um instrumento para conseguir discriminar objectos, e é função do tamanho do detector, da distância focal e da altitude orbital do sensor” (NASA, 2013); a resolução espacial de um detector também é definida em função das suas características geométricas, nomeadamente pelo seu campo de vista instantâneo (IFOV - “Instantaneous Field Of View”);

A resolução espectral é o número e a amplitude dos intervalos de comprimentos de onda nos quais a radiação electromagnética é registada; quanto mais estreitos forem os intervalos, maior a resolução espectral; cada um desses intervalos designa-se por banda espectral; nos sensores multiespectrais, a cada banda corresponde uma imagem;

A resolução radiométrica, normalmente medida em bits (“binary digits”), é a amplitude de níveis de brilho disponíveis, que na imagem corresponde ao intervalo máximo de valores digitais (DNs); por exemplo, uma imagem com resolução radiométrica de 8 bits tem 256 níveis de brilho (Richards and Jia, 2006), numerados de 0 a 255;

Para os sensores a bordo dos satélites existe ainda a resolução temporal, que corresponde ao intervalo de tempo entre a aquisição de imagens do mesmo local ou, mais simplesmente, ao tempo necessário para o satélite revisitar a mesma área da Terra (NASA, 2013).

3.1.4. Radiância e Reflectância¶

Os sensores medem a radiância, que corresponde ao brilho numa determinada direcção em relação ao sensor; que é útil para definir a reflectância como uma razão entre a energia radiante reflectida e a energia radiante total.

3.1.5. Assinatura Espectral¶

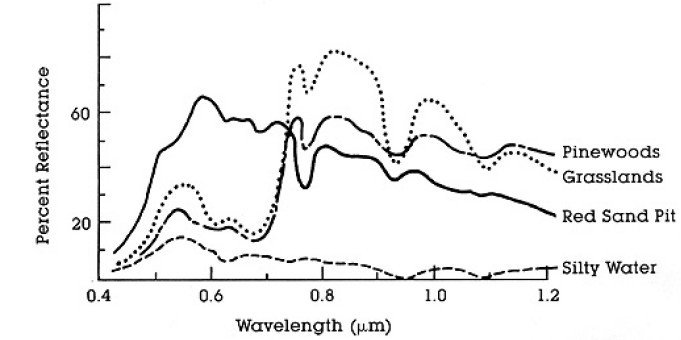

A assinatura espectral, traduzida pela curva de reflectância espectral, corresponde à reflectância em função do comprimento de onda (ver Figura Curvas de Reflectância Espectral para quatro elementos diferentes - água com sedimentos, areia, pastagens, pinhal); cada material possui uma assinatura espectral única, pelo que isso pode ser utilizado para se fazer a classificação dos materiais (NASA, 2013).

Curvas de Reflectância Espectral para quatro elementos diferentes - água com sedimentos, areia, pastagens, pinhal

(in NASA, 2013)

3.1.6. Satélites Landsat¶

Landsat é um conjunto de satélites multiespectrais desenvolvidos pela NASA (National Aeronautics and Space Administration dos Estados Unidos da América), desde o início dos anos 70 do século XX.

As imagens Landsat são muito utilizadas na investigação ambiental e na observação da Terra. As resoluções dos satélites Landsat 4 e Landsat 5 são apresentadas na tabela seguinte (retirada de http://landsat.usgs.gov/band_designations_landsat_satellites.php); a resolução temporal das imagens dos satélites Landsat é de 16 dias (NASA, 2013).

Landsat 4 and Landsat 5 Bands

Bandas Landsat 4, Landsat 5 |

Comprimento de onda [micrómetros] |

Resolução [metros] |

|---|---|---|

Banda 1 - Azul |

0.45 - 0.52 | 30 |

Banda 2 - Verde |

0.52 - 0.60 | 30 |

Banda 3 - Vermelho |

0.63 - 0.69 | 30 |

Banda 4 - Infravermelho próximo (NIR) |

0.76 - 0.90 | 30 |

Banda 5 - Infravermelho médio (SWIR) |

1.55 - 1.75 | 30 |

Banda 6 - Infravermelho térmico (TIRS) |

10.40 - 12.50 | 120 (reamostrada para 30) |

Banda 7 - Infravermelho médio (SWIR) |

2.08 - 2.35 | 30 |

As resoluções do Landsat 7 são apresentadas na tabela seguinte (retirada de http://landsat.usgs.gov/band_designations_landsat_satellites.php); a resolução temporal das imagens deste satélite é também de 16 dias (NASA, 2013).

Landsat 7 Bands

Bandas Landsat 7 |

Comprimento de onda [micrómetros] |

Resolução [metros] |

|---|---|---|

Banda 1 - Azul |

0.45 - 0.52 | 30 |

Banda 2 - Verde |

0.52 - 0.60 | 30 |

Banda 3 - Vermelho |

0.63 - 0.69 | 30 |

Banda 4 - Infravermelho próximo (NIR) |

0.77 - 0.90 | 30 |

Banda 5 - Infravermelho médio (SWIR) |

1.57 - 1.75 | 30 |

Banda 6 - Infravermelho térmico (TIRS) |

10.40 - 12.50 | 60 (reamostrada para 30) |

Banda 7 - Infravermelho médio (SWIR) |

2.09 - 2.35 | 30 |

Banda 8 - Pancromática |

0.52 - 0.90 | 15 |

As resoluções do Landsat 8 são apresentadas na tabela seguinte (retirada de http://landsat.usgs.gov/band_designations_landsat_satellites.php); a resolução temporal das imagens deste satélite é também de 16 dias (NASA, 2013).

Landsat 8 Bands

Bandas Landsat 8 |

Comprimento de onda [micrómetros] |

Resolução [metros] |

|---|---|---|

Banda 1 - Ultra-azul (estudos costeiros e aerossóis) |

0.43 - 0.45 | 30 |

Banda 2 - Azul |

0.45 - 0.51 | 30 |

Banda 3 - Verde |

0.53 - 0.59 | 30 |

Banda 4 - Vermelho |

0.64 - 0.67 | 30 |

Banda 5 - Infravermelho próximo (NIR) |

0.85 - 0.88 | 30 |

Banda 6 - Infravermelho médio (SWIR) |

1.57 - 1.65 | 30 |

Banda 7 - Infravermelho médio (SWIR) |

2.11 - 2.29 | 30 |

Banda 8 - Pancromática |

0.50 - 0.68 | 15 |

Banda 9 - Cirros (detecção de nuvens) |

1.36 - 1.38 | 30 |

Banda 10 - Infravermelho térmico (TIRS) 1 |

10.60 - 11.19 | 100 (reamostrada para 30) |

Banda 11 - Infravermelho térmico (TIRS) 2 |

11.50 - 12.51 | 100 (reamostrada para 30) |

A vast archive of images is freely available from the U.S. Geological Survey . For more information about how to freely download Landsat images read this .

Images are identified with the paths and rows of the WRS (Worldwide Reference System for Landsat ).

3.1.7. Satélite Sentinel-2¶

O Sentinel-2 é um satélite multiespectral desenvolvido pela Agência Espacial Europeia (ESA), no quadro do programa Copernicus de serviços de monitorização da Terra. O Sentinel-2 possui 13 bandas espectrais com resolução espacial de 10m, 20m e 60m, dependendo da banda em questão, conforme se encontra ilustrado na tabela seguinte (ESA, 2015).

Sentinel-2 Bands

Bandas Sentinel-2 |

Comprimento de onda central [micrómetros] |

Resolução [metros] |

|---|---|---|

Banda 1 - Ultra-azul (estudos costeiros e aerossóis) |

0.443 | 60 |

Banda 2 - Azul |

0.490 | 10 |

Banda 3 - Verde |

0.560 | 10 |

Banda 4 - Vermelho |

0.665 | 10 |

Banda 5 - Red Edge (vegetação) |

0.705 | 20 |

Banda 6 - Red Edge (vegetação) |

0.740 | 20 |

Banda 7 - Red Edge (vegetação) |

0.783 | 20 |

Banda 8 - Infravermelho próximo (NIR) |

0.842 | 10 |

| Band 8A - Vegetation Red Edge | 0.865 | 20 |

Banda 9 - Vapor de água |

0.945 | 60 |

Banda 10 - Infravermelho médio (SWIR) - Cirros |

1.375 | 60 |

Banda 11 - Infravermelho médio (SWIR) |

1.610 | 20 |

Banda 12 - Infravermelho médio (SWIR) |

2.190 | 20 |

As imagens Sentinel-2 são disponibilizadas gratuitamente no site da ESA https://scihub.esa.int/dhus/ .

3.1.8. ASTER Satellite¶

The ASTER (Advanced Spaceborne Thermal Emission and Reflection Radiometer) satellite was launched in 1999 by a collaboration between the Japanese Ministry of International Trade and Industry (MITI) and the NASA. ASTER has 14 bands whose spatial resolution varies with wavelength: 15m in the visible and near-infrared, 30m in the short wave infrared, and 90m in the thermal infrared (USGS, 2015). ASTER bands are illustrated in the following table (due to a sensor failure SWIR data acquired since April 1, 2008 is not available ). An additional band 3B (backwardlooking near-infrared) provides stereo coverage.

ASTER Bands

| ASTER Bands | Comprimento de onda [micrómetros] |

Resolução [metros] |

|---|---|---|

| Band 1 - Green | 0.52 - 0.60 | 15 |

| Band 2 - Red | 0.63 - 0.69 | 15 |

| Band 3N - Near Infrared (NIR) | 0.78 - 0.86 | 15 |

| Band 4 - SWIR 1 | 1.60 - 1.70 | 30 |

| Band 5 - SWIR 2 | 2.145 - 2.185 | 30 |

| Band 6 - SWIR 3 | 2.185 - 2.225 | 30 |

| Band 7 - SWIR 4 | 2.235 - 2.285 | 30 |

| Band 8 - SWIR 5 | 2.295 - 2.365 | 30 |

| Band 9 - SWIR 6 | 2.360 - 2.430 | 30 |

| Band 10 - TIR 1 | 8.125 - 8.475 | 90 |

| Band 11 - TIR 2 | 8.475 - 8.825 | 90 |

| Band 12 - TIR 3 | 8.925 - 9.275 | 90 |

| Band 13 - TIR 4 | 10.25 - 10.95 | 90 |

| Band 14 - TIR 5 | 10.95 - 11.65 | 90 |

3.1.9. MODIS Products¶

The MODIS (Moderate Resolution Imaging Spectroradiometer) is an instrument operating on the Terra and Aqua satellites launched by NASA in 1999 and 2002 respectively. Its temporal resolutions allows for viewing the entire Earth surface every one to two days, with a swath width of 2,330. Its sensors measure 36 spectral bands at three spatial resolutions: 250m, 500m, and 1,000m (see https://lpdaac.usgs.gov/dataset_discovery/modis).

Several products are available, such as surface reflectance and vegetation indices. In this manual we are considering the surface reflectance bands available at 250m and 500m spatial resolution (Vermote, Roger, & Ray, 2015).

MODIS Bands

| MODIS Bands | Comprimento de onda [micrómetros] |

Resolução [metros] |

|---|---|---|

| Band 1 - Red | 0.62 - 0.67 | 250 - 500 |

| Band 2 - Near Infrared (NIR) | 0.841 - 0.876 | 250 - 500 |

| Band 3 - Blue | 0.459 - 0.479 | 500 |

| Band 4 - Green | 0.545 - 0.565 | 500 |

| Band 5 - SWIR 1 | 1.230 - 1.250 | 500 |

| Band 6 - SWIR 2 | 1.628 - 1.652 | 500 |

| Band 7 - SWIR 3 | 2.105 - 2.155 | 500 |

The following products (Version 6, see https://lpdaac.usgs.gov/dataset_discovery/modis/modis_products_table) are available for download (Vermote, Roger, & Ray, 2015):

- MOD09GQ: daily reflectance at 250m spatial resolution from Terra MODIS;

- MYD09GQ: daily reflectance at 250m spatial resolution from Aqua MODIS;

- MOD09GA: daily reflectance at 500m spatial resolution from Terra MODIS;

- MYD09GA: daily reflectance at 500m spatial resolution from Aqua MODIS;

- MOD09Q1: reflectance at 250m spatial resolution, which is a composite of MOD09GQ (each pixel contains the best possible observation during an 8-day period);

- MYD09Q1: reflectance at 250m spatial resolution, which is a composite of MYD09GQ (each pixel contains the best possible observation during an 8-day period);

- MOD09A1: reflectance at 250m spatial resolution, which is a composite of MOD09GA (each pixel contains the best possible observation during an 8-day period);

- MYD09A1: reflectance at 250m spatial resolution, which is a composite of MYD09GA (each pixel contains the best possible observation during an 8-day period);

3.1.10. Composição Colorida¶

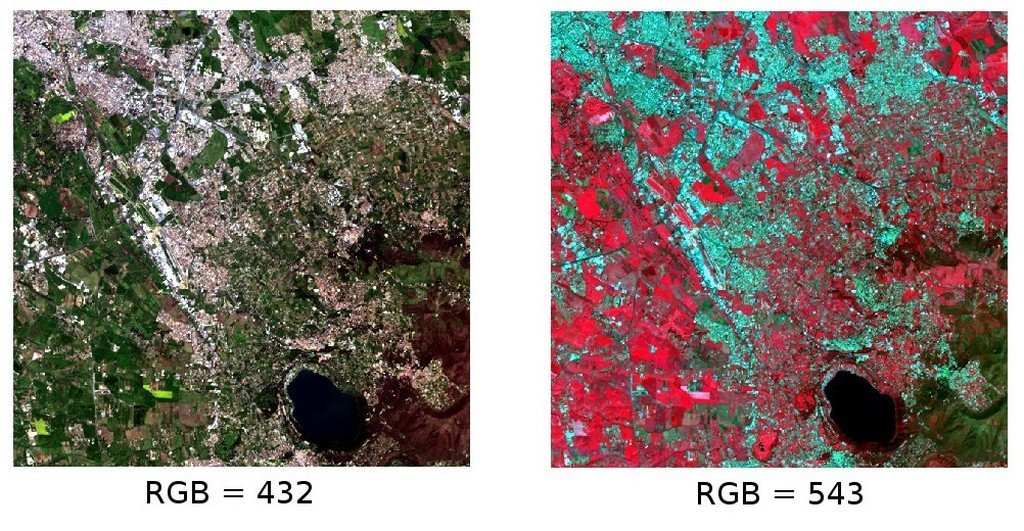

Muitas vezes, é criada uma combinação de três imagens monocromáticas, na qual cada imagem é atribuída a uma determinada cor; este conjunto é designado por composição colorida e é muito útil para fotointerpretação (NASA, 2013). As composições coloridas são geralmente expressas como:

“R G B = Br Bg Bb”

onde:

R corresponde ao Vermelho;

G corresponde ao Verde;

B corresponde ao Azul;

Br é o número da banda associada à cor Vermelha;

Bg é o número da banda associada à cor Verde;

Bb é o número da banda associada à cor Azul;

The following Figure Composição colorida de uma imagem Landsat 8 shows a color composite “R G B = 4 3 2” of a Landsat 8 image (for Landsat 7 the same color composite is R G B = 3 2 1; for Sentinel-2 is R G B = 4 3 2) and a color composite “R G B = 5 4 3” (for Landsat 7 the same color composite is R G B = 4 3 2; for Sentinel-2 is R G B = 8 4 3). The composite “R G B = 5 4 3” is useful for the interpretation of the image because vegetation pixels appear red (healthy vegetation reflects a large part of the incident light in the near-infrared wavelength, resulting in higher reflectance values for band 5, thus higher values for the associated color red).

Composição colorida de uma imagem Landsat 8

Dados disponibilizados pelos Serviços Geológicos dos Estados Unidos da América - USGS

3.1.11. Principal Component Analysis¶

Principal Component Analysis (PCA) is a method for reducing the dimensions of measured variables (bands) to the principal components (JARS, 1993).

Th principal component transformation provides a new set of bands (principal components) having the following characteristic: principal components are uncorrelated; each component has variance less than the previous component. Therefore, this is an efficient method for extracting information and data compression (Ready and Wintz, 1973).

Given an image with N spectral bands, the principal components are obtained by matrix calculation (Ready and Wintz, 1973; Richards and Jia, 2006):

onde:

- \(Y\) = vector of principal components

- \(D\) = matrix of eigenvectors of the covariance matrix \(C_x\) in X space

- \(t\) denotes vector transpose

And \(X\) is calculated as:

- \(P\) = vector of spectral values associated with each pixel

- \(M\) = vector of the mean associated with each band

Thus, the mean of \(X\) associated with each band is 0. \(D\) is formed by the eigenvectors (of the covariance matrix \(C_x\)) ordered as the eigenvalues from maximum to minimum, in order to have the maximum variance in the first component. This way, the principal components are uncorrelated and each component has variance less than the previous component(Ready and Wintz, 1973).

Usually the first two components contain more than the 90% of the variance. For example, the first principal components can be displayed in a Composição Colorida for highlighting Cobertura do Solo classes, or used as input for Classificação Supervisada.

3.1.12. Pan-sharpening (Fusão)¶

Pan-sharpening is the combination of the spectral information of multispectral bands (MS), which have lower spatial resolution (for Landsat bands, spatial resolution is 30m), with the spatial resolution of a panchromatic band (PAN), which for Landsat 7 and 8 it is 15m. The result is a multispectral image with the spatial resolution of the panchromatic band (e.g. 15m). In SCP, a Brovey Transform is applied, where the pan-sharpened values of each multispectral band are calculated as (Johnson, Tateishi and Hoan, 2012):

onde \(I\) é a Intensidade, que é dependente das bandas multiespectrais.

The following weights for I are defined, basing on several tests performed using the SCP. For Landsat 8, Intensity is calculated as:

Para o Landsat 7, a Intensidade é calculada como:

Exemplo da fusão de uma imagem Landsat 8. À esquerda, a composição multiespectral original (30m); à direita, a imagem após a fusão (15m)

Dados disponibilizados pelos Serviços Geológicos dos Estados Unidos da América - USGS

3.1.13. Spectral Indices¶

Spectral indices are operations between spectral bands that are useful for extracting information such as vegetation cover (JARS, 1993). One of the most popular spectral indices is the Normalized Difference Vegetation Index (NDVI), defined as (JARS, 1993):

NDVI values range from -1 to 1. Dense and healthy vegetation show higher values, while non-vegetated areas show low NDVI values.

Another index is the Enhanced Vegetation Index (EVI) which attempts to account for atmospheric effects such as path radiance calculating the difference between the blue and the red bands (Didan,et al., 2015). EVI is defined as:

where: \(G\) is a scaling factor, \(C_1\) and \(C_2\) are coefficients for the atmospheric effects, and \(L\) is a factor for accounting the differential NIR and Red radiant transfer through the canopy. Typical coefficient values are: \(G = 2.5\), \(L = 1\), \(C_1 = 6\), \(C_2 = 7.5\) (Didan,et al., 2015).

3.2. Classificação Supervisada - Definições¶

Este capítulo apresenta as noções básicas acerca da classificação supervisada.

3.2.1. Cobertura do Solo¶

A Cobertura do Solo corresponde à identificação do material que existe na superfície terrestre, através das suas características biofísicas, como por exemplo, solo, vegetação, água, asfalto, etc. (Fisher and Unwin, 2005). Dependendo da resolução dos sensores, o número e o tipo de unidades/classes de cobertura do solo que podem ser discriminadas através das imagens de satélite, varia consideravelmente.

3.2.2. Classificação Supervisada¶

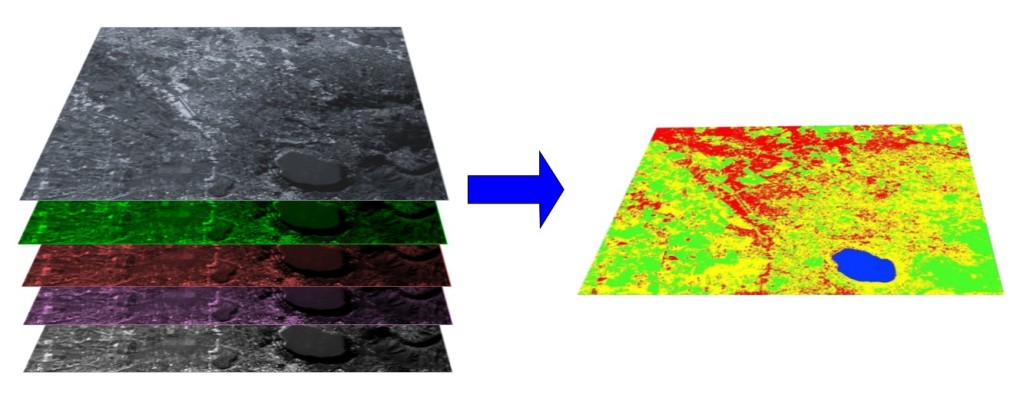

A classificação semiautomática (também designada classificação supervisada) é uma técnica de processamento digital de imagem que permite a identificação dos materiais/objectos presentes na imagem, através da sua assinatura espectral. A classificação digital corresponde a um processo de extracção de informação através da análise das assinaturas espectrais dos materiais presentes em cada pixel, separando-os em classes, consoante a similaridade das suas assinaturas. Existem diversos tipos de algoritmos de classificação mas, em geral, todos têm como principal objectivo a criação de cartografia temática representativa da cobertura do solo.

O processamento digital de imagem e a análise espacial SIG requerem a utilização de software específico, como é o caso do Semi-Automatic Classification Plugin para o QGIS.

A multispectral image processed to produce a land cover classification

(Landsat image provided by USGS)3.2.3. Áreas de Treino¶

Normalmente, a classificação supervisada exige que o operador defina uma ou mais Regiões de Interesse (ROIs, ou Áreas de Treino) para cada tipo de cobertura do solo identificada na imagem. As ROIs são, na prática, polígonos desenhados sobre regiões homogéneas da imagem, cujos pixeis sejam representativos de cada classe de cobertura do solo.

3.2.3.1. Region Growing Algorithm¶

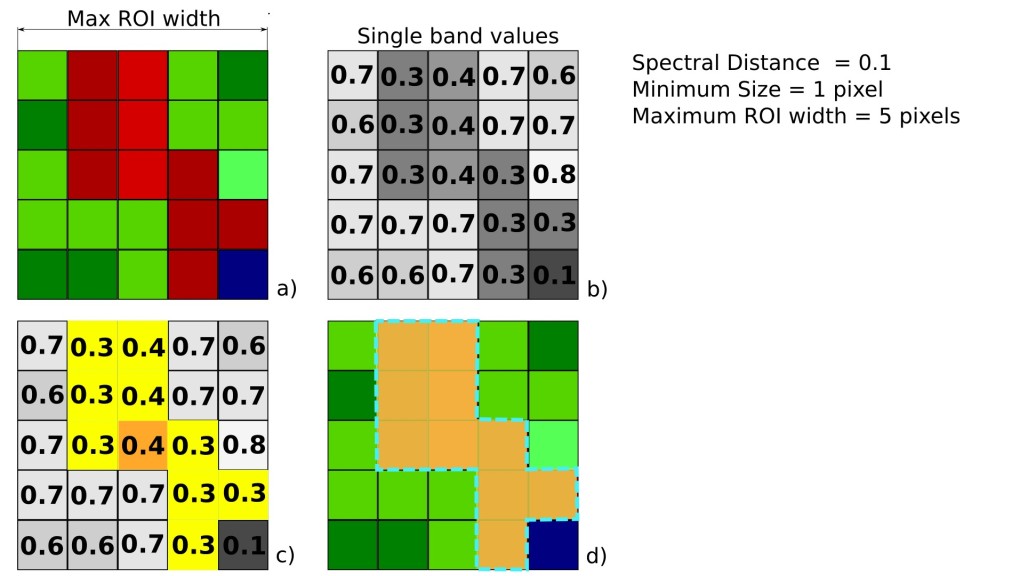

The Region Growing Algorithm allows to select pixels similar to a seed one, considering the spectral similarity (i.e. spectral distance) of adjacent pixels. In SCP the Region Growing Algorithm is available for the training area creation. The parameter distance is related to the similarity of pixel values (the lower the value, the more similar are selected pixels) to the seed one (i.e. selected clicking on a pixel). An additional parameter is the maximum width, which is the side length of a square, centred at the seed pixel, which inscribes the training area (if all the pixels had the same value, the training area would be this square). The minimum size is used a constraint (for every single band), selecting at least the pixels that are more similar to the seed one until the number of selected pixels equals the minimum size.

In figure Region growing example the central pixel is used as seed (image a) for the region growing of one band (image b) with the parameter spectral distance = 0.1; similar pixels are selected to create the training area (image c and image d).

Region growing example

3.2.4. Classes e Macroclasses¶

Land cover classes are identified with an arbitrary ID code (i.e. Identifier).

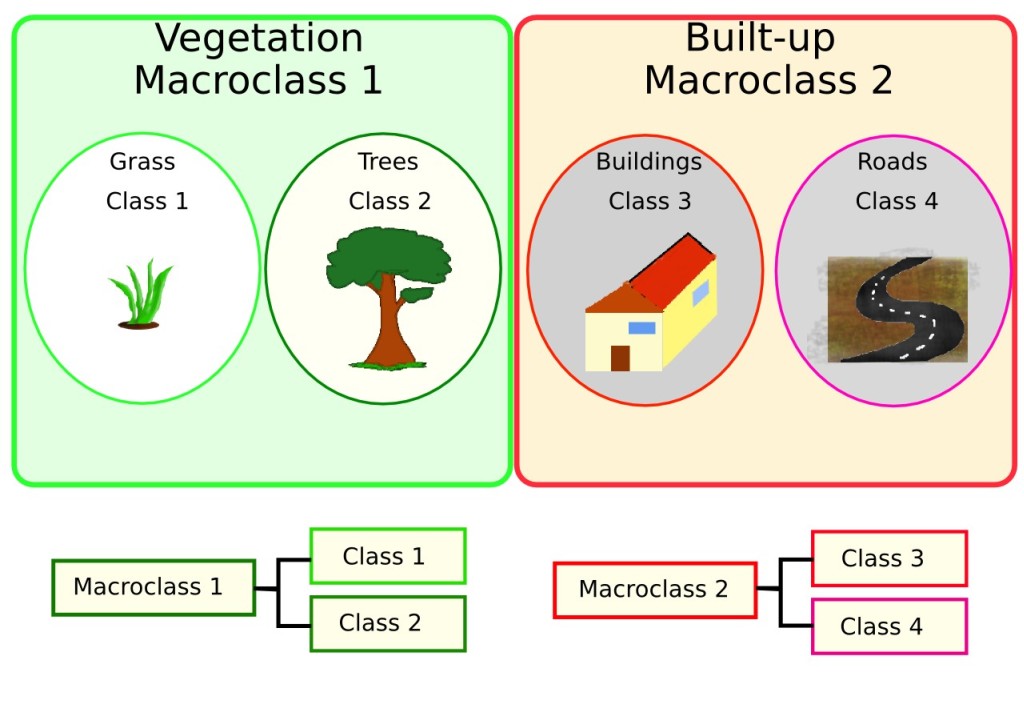

SCP allows for the definition of Macroclass ID (i.e. MC ID) and Class ID (i.e. C ID), which are the identification codes of land cover classes.

A Macroclass is a group of ROIs having different Class ID, which is useful when one needs to classify materials that have different spectral signatures in the same land cover class.

For instance, one can identify grass (e.g. ID class = 1 and Macroclass ID = 1 ) and trees (e.g. ID class = 2 and Macroclass ID = 1 ) as vegetation class (e.g. Macroclass ID = 1 ).

Multiple Class IDs can be assigned to the same Macroclass ID, but the same Class ID cannot be assigned to multiple Macroclass IDs, as shown in the following table.

Example of Macroclasses

Nome da Macroclasse |

ID da Macroclasse |

Nome da Classe |

ID da Classe |

|---|---|---|---|

Vegetação |

1 | Erva |

1 |

Vegetação |

1 | Árvores |

2 |

Construído |

2 | Buildings | 3 |

Construído |

2 | Roads | 4 |

Deste modo, as Classes são subconjuntos de uma Macroclasse, conforme ilustrado na Figura Examplo de uma Macroclasse.

Examplo de uma Macroclasse

Se a utilização de Macroclasses não é necessária para os objectivos do estudo, então pode ser atribuído o mesmo ID de Macroclasse a todas as ROIs (por exemplo, Macroclass ID = 1), sendo que os valores da Macroclasse serão, nesta situação, ignorados pelo processo de classificação.

3.2.5. Algoritmos de Classificação¶

The spectral signatures (spectral characteristics) of reference land cover classes are calculated considering the values of pixels under each ROI having the same Class ID (or Macroclass ID). Therefore, the classification algorithm classifies the whole image by comparing the spectral characteristics of each pixel to the spectral characteristics of reference land cover classes. SCP implements the following classification algorithms.

3.2.5.1. Mínima Distância¶

O algoritmo de Mínima Distância é um classificador estatístico que calcula a distância Euclidiana \(d(x, y)\) entre as assinaturas espectrais dos pixeis da imagem e as assinaturas espectrais das áreas de treino, de acordo com a seguinte equação:

onde:

\(x\) = vector assinatura espectral de um pixel na imagem;

\(y\) = vector assinatura espectral de uma área de treino;

\(n\) = numero de bandas da imagem, utilizadas na classificação.

Assim, a distância é calculada para cada pixel na imagem, inserindo-o na classe que possuir assinatura espectral mais próxima, de acordo com a função discriminante seguinte (adaptado de Richards e Jia, 2006):

onde:

\(C_k\) = classe de cobertura do solo \(k\);

\(y_k\) = assinatura espectral da classe \(k\);

\(y_j\) = assinatura espectral da classe \(j\).

É possível definir um limiar \(T_i\) por forma a excluir da classificação, pixels com valor abaixo desse limiar:

3.2.5.2. Máxima Verosimilhança¶

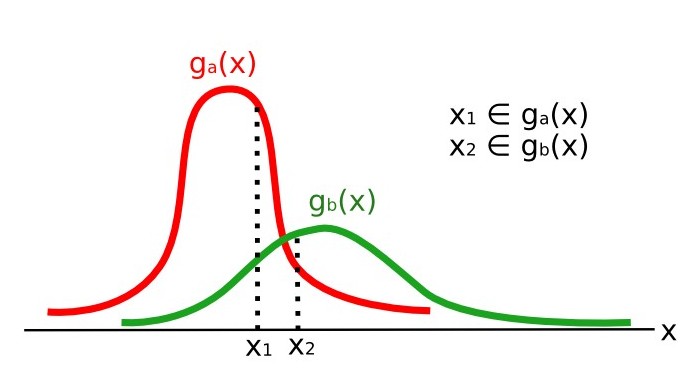

O algoritmo de Máxima Verosimilhança calcula as distribuições de probabilidade para as classes, relacionadas com o teorema de Bayes, estimando, dessa forma, se um pixel pertence a uma determinada classe de cobertura do solo. Em particular, as distribuições de probabilidade para as classes assumem a forma de modelos normais multivariados (Richards & Jia, 2006). Para utilizar este algoritmo, é necessário um número significativo de pixeis para cada área de treino, permitindo o cálculo de matrizes de covariância. A função discriminante, descrita por Richards e Jia (2006), é calculada, para cada pixel, como:

onde:

\(C_k\) = classe de cobertura do solo \(k\);

\(x\) = vector assinatura espectral do pixel da imagem;

\(p(C_k)\) = probabilidade da classe correcta ser \(C_k\);

\(| \Sigma_{k} |\) = determinante da matriz de covariância dos dados na classe \(C_k\);

\(\Sigma_{k}^{-1}\) = inversa da matriz de covariância;

\(y_k\) = vector assinatura espectral da classe \(k\).

Portanto:

Maximum Likelihood example

Adicionalmente, é possível definir um limiar para a função discriminante, de modo a excluir da classificação pixeis com valor abaixo desse limiar. Considerando um limiar \(T_i\) a condição de classificação fica:

O classificador Máxima Verosimilhança é um dos algoritmos de classificação supervisada mais comuns, contudo, o processo de classificação pode ser mais lento que o Mínima Distância.

3.2.5.3. Spectral Angle Mapping¶

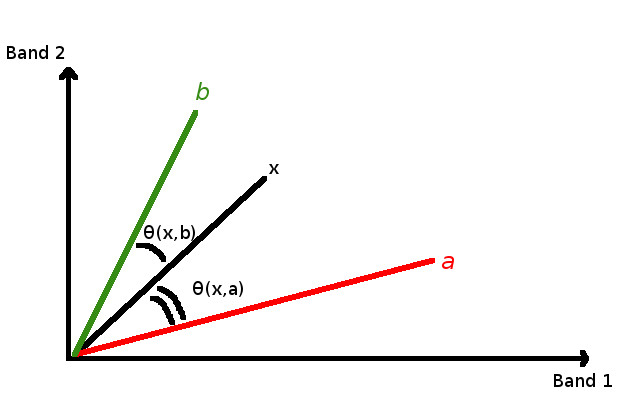

O algoritmo de Mapeamento de Ângulo Espectral calcula o ângulo espectral entre as assinaturas espectrais dos pixeis da imagem e as assinaturas espectrais das áreas de treino. O ângulo espectral \(\theta\) é definido como (Kruse et al., 1993):

Onde:

\(x\) = vector assinatura espectral de um pixel na imagem;

\(y\) = vector assinatura espectral de uma área de treino;

\(n\) = numero de bandas da imagem, utilizadas na classificação.

Por conseguinte, um pixel pertence à classe que possui o menor ângulo, ou seja:

onde:

\(C_k\) = classe de cobertura do solo \(k\);

\(y_k\) = assinatura espectral da classe \(k\);

\(y_j\) = assinatura espectral da classe \(j\).

Spectral Angle Mapping example

Para excluir da classificação pixeis com valor abaixo de um determinado limiar, é possível definir esse limiar \(T_i\):

O Mapeamento de Ângulo Espectral é muito utilizado, especialmente quando se trabalha com dados provenientes de sensores hiperespectrais.

3.2.5.4. Parallelepiped Classification¶

Parallelepiped classification is an algorithm that considers a range of values for each band, forming a multidimensional parallelepiped that defines a land cover class. A pixel is classified if the values thereof are inside a parallelepiped. One of the major drawbacks is that pixels whose signatures lie in the overlapping area of two or more parallelepipeds cannot be classified (Richards and Jia, 2006).

3.2.5.5. Land Cover Signature Classification¶

Land Cover Signature Classification is available in SCP (see Land Cover Signature Classification). This classification allows for the definition of spectral thresholds for each training input signature (a minimum value and a maximum value for each band). The thresholds of each training input signature define a spectral region belonging to a certain land cover class.

Spectral signatures of image pixels are compared to the training spectral signatures; a pixel belongs to class X if pixel spectral signature is completely contained in the spectral region defined by class X.

In case of pixels falling inside overlapping regions or outside any spectral region, it is possible to use additional classification algorithms (i.e. Mínima Distância, Máxima Verosimilhança, Spectral Angle Mapping) considering the spectral characteristics of the original input signature.

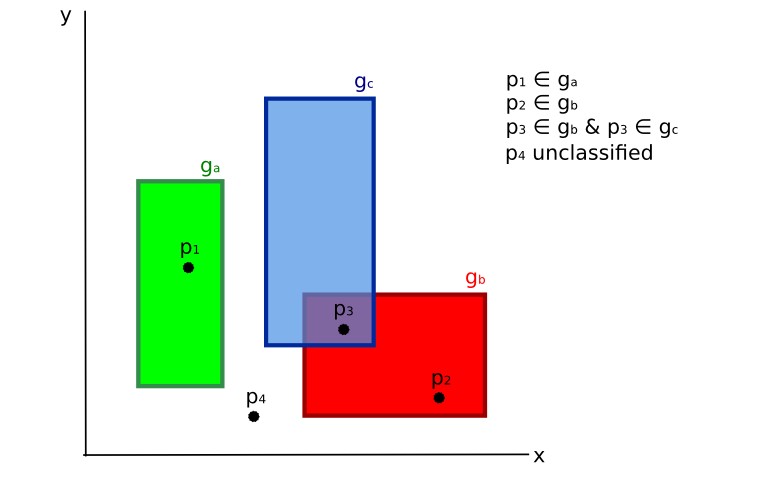

In the following image, a scheme illustrates the Land Cover Signature Classification for a simple case of two spectral bands \(x\) and \(y\). User defined spectral regions define three classes (\(g_a\), \(g_b\), and \(g_c\)). Point \(p_1\) belongs to class \(g_a\) and point \(p_2\) belongs to class \(g_b\). However, point \(p_3\) is inside the spectral regions of both classes \(g_b\) and \(g_c\) (overlapping regions); in this case, point \(p_3\) will be unclassified or classified according to an additional classification algorithm. Point \(p_4\) is outside any spectral region, therefore it will be unclassified or classified according to an additional classification algorithm. Given that point \(p_4\) belongs to class \(g_c\), the spectral region thereof could be extended to include point \(p_4\) .

Land cover signature classification

This is similar to Parallelepiped Classification, with the exception that spectral regions are defined by user, and can be assigned independently for the upper and lower bounds. One can imagine spectral regions as the set of all the spectral signatures of pixels belonging to one class.

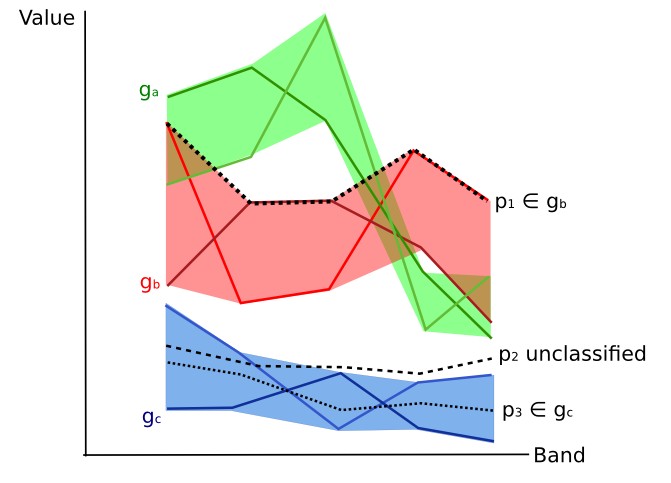

In figure Plot of spectral ranges the spectral ranges of three classes (\(g_a\), \(g_b\), and \(g_c\)) are displayed; the colored lines inside the ranges (i.e. semi-transparent area) represent the spectral signatures of pixels that defined the upper and lower bounds of the respective ranges. Pixel \(p_1\) (dotted line) belongs to class \(g_b\) because the spectral signature thereof is completely inside the range of class \(g_b\) (in the upper limit); pixel \(p_2\) (dashed line) is unclassified because the spectral signature does not fall completely inside any range; pixel \(p_3\) (dotted line) belongs to class \(g_a\).

Plot of spectral ranges

It is worth noticing that these spectral thresholds can be applied to any spectral signature, regardless of spectral characteristics thereof; this function can be very useful for separating similar spectral signatures that differ only in one band, defining thresholds that include or exclude specific signatures. In fact, classes are correctly separated if the spectral ranges thereof are not overlapping at least in one band. Of course, even if spectral regions are overlapping, chances are that no pixel will fall inside the overlapping region and be misclassified; which is the upper (or lower) bound of a range do not imply the existence, in the image, of any spectral signature having the maximum (or minimum) range values for all the bands (for instance pixel \(p_1\) of figure Plot of spectral ranges could not exist).

One of the main benefit of the Land Cover Signature Classification is that it is possible to select pixels and and include the signature thereof in a spectral range; therefore, the classification should be the direct representation of the class expected for every spectral signature. This is very suitable for the classification of a single land cover class (defined by specific spectral thresholds), and leave unclassified the rest of the image that is of no interest for the purpose of the classification.

3.2.5.6. Algorithm raster¶

An algorithm raster represents the “distance” (according to the definition of the classification algorithm) of an image pixel to a specific spectral signature.

In general, an algorithm raster is produced for every spectral signature used as training input.

The value of every pixel is the result of the algorithm calculation for a specific spectral signature.

Therefore, a pixel belongs to class X if the value of the algorithm raster corresponding to class X is the lowest in case of Mínima Distância or Spectral Angle Mapping (or highest in case of Máxima Verosimilhança).

Given a classification, a combination of algorithm rasters can be produced, in order to create a raster with the lowest “distances” (i.e. pixels have the value of the algorithm raster corresponding to the class they belong in the classification). Therefore, this raster can be useful to identify pixels that require the collection of more similar spectral signatures (see Classification preview).

3.2.6. Distância Espectral¶

It is useful to evaluate the spectral distance (or separability) between training signatures or pixels, in order to assess if different classes that are too similar could cause classification errors. The SCP implements the following algorithms for assessing similarity of spectral signatures.

3.2.6.1. Distância de Jeffries-Matusita¶

A Distância de Jeffries-Matusita calcula a separabilidade de um par de distribuições de probabilidade. Isto pode ser particularmente significativo para avaliar os resultados de classificações onde se utilizou o algoritmo de Máxima Verosimilhança .

A Distância de Jeffries-Matusita \(J_{xy}\) é calculada como (Richards and Jia, 2006):

onde:

onde:

\(x\) = primeiro vector assinatura espectral;

\(y\) = segundo vector assinatura espectral;

\(\Sigma_{x}\) = matriz de covariância da amostra \(x\);

\(\Sigma_{y}\) = matriz de covariância da amostra \(y\);

A Distância de Jeffries-Matusita é assimptótica para 2 quando as assinaturas são completamente diferentes, e tendem para 0 quando as assinaturas são idênticas.

3.2.6.2. Ângulo Espectral¶

O Ângulo Espectral é o mais apropriado para avaliar o algoritmo de Spectral Angle Mapping . O ângulo espectral \(\theta\) é definido como (Kruse et al., 1993):

Onde:

\(x\) = vector assinatura espectral de um pixel na imagem;

\(y\) = vector assinatura espectral de uma área de treino;

\(n\) = numero de bandas da imagem, utilizadas na classificação.

O ângulo espectral varia de 0, quando as assinaturas são idênticas, a 90, quando as assinaturas são completamente diferentes.

3.2.6.3. Distância Euclidiana¶

A Distância Euclidiana é particularmente útil para avaliar os resultados das classificações com o algoritmo de:ref:minimum_distance_algorithm . Na realidade, a distância é definida como:

onde:

\(x\) = primeiro vector assinatura espectral;

\(y\) = segundo vector assinatura espectral;

\(n\) = numero de bandas da imagem, utilizadas na classificação.

A Distância Euclidiana é 0, quando as assinaturas são idênticas, e tende a aumentar de acordo com a distância espectral das assinaturas.

3.2.6.4. Similaridade de Bray-Curtis¶

A Similaridade de Bray-Curtis é uma análise estatística utilizada para avaliar a relação entre duas amostras (ler aqui). É útil, em geral, para avaliar a similaridade das assinaturas espectrais, e a Similaridade de Bray-Curtis \(S(x, y)\) é calculada como:

onde:

\(x\) = primeiro vector assinatura espectral;

\(y\) = segundo vector assinatura espectral;

\(n\) = numero de bandas da imagem, utilizadas na classificação.

A Similaridade de Bray-Curtis é calculada em percentagem e varia de 0, quando as assinaturas são completamente diferentes, até 100, quando as assinaturas espectrais são idênticas.

3.2.7. Resultado da Classificação¶

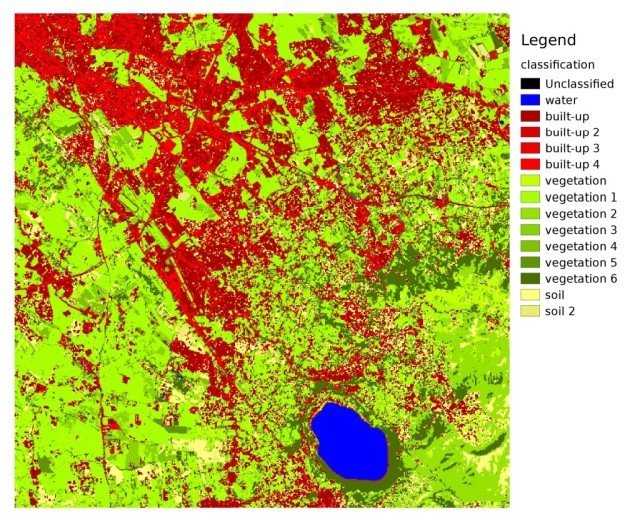

O resultado do processo de classificação é um raster (exemplo da Classificação de uma imagem Landsat na figura seguinte), onde o valor dos pixeis corresponde aos IDs das classes e cada cor representa uma classe de cobertura do solo.

Classificação de uma imagem Landsat

Dados disponibilizados pelos Serviços Geológicos dos Estados Unidos da América - USGS

No processo de classificação da cobertura do solo, é expectável a ocorrência de uma certa quantidade de erros (isto é, pixeis atribuídos erroneamente a uma data classe de cobertura do solo), devido à similaridade espectral entre as classes, e/ou à definição errada de classes durante a recolha de áreas de treino (ROIs).

3.2.8. Avaliação de Precisão¶

Após o processo de classificação, é muito útil avaliar a precisão da classificação da cobertura do solo, de modo a identificar e quantificar erros de mapeamento. Normalmente, a avaliação da precisão é realizada através do cálculo da matriz de contingências, que é uma tabela que compara a informação do mapa resultante da classificação, com dados de referência (isto é, dados verificados e validados no terreno), para um determinado conjunto de áreas de amostra (Congalton and Green, 2009).

A tabela seguinte é um esquema de uma matriz de contingências, onde k é o número de classes identificadas no processo de classificação de cobertura do solo, e n é o número total de unidades amostra (áreas de verificação e validação) recolhidos. Os itens na diagonal principal da matriz (aii) correspondem ao número de amostras correctamente classificadas, enquanto que os restantes itens representam erros de classificação.

Scheme of Error Matrix

Amostra de referência 1 |

Amostra de referência 2 |

… | Amostra de referência k |

Total | |

|---|---|---|---|---|---|

Classe 1 |

\(a_{11}\) | \(a_{12}\) | … | \(a_{1k}\) | \(a_{1+}\) |

Classe 2 |

\(a_{21}\) | \(a_{22}\) | … | \(a_{2k}\) | \(a_{2+}\) |

| … | … | … | … | … | … |

Classe k |

\(a_{k1}\) | \(a_{k2}\) | … | \(a_{kk}\) | \(a_{k+}\) |

| Total | \(a_{+1}\) | \(a_{+2}\) | … | \(a_{+k}\) | \(n\) |

Desta forma, é possível calcular a precisão global da classificação como a razão entre o número de amostras correctamente classificadas (soma da diagonal principal da matriz) e o número total de unidades amostra n (Congalton and Green, 2009). Esta é a estatística descritiva mais simples que se pode determinar a partir da tabela de contingências, e é geralmente designada por percentagem de elementos correctamente classificados - PECC.

Para mais informações, a seguinte documentação encontra-se disponível gratuitamente: Landsat 7 Science Data User’s Handbook, Remote Sensing Note , ou Wikipedia.

3.3. Image conversion to reflectance¶

This chapter provides information about the conversion to reflectance implemented in SCP.

3.3.1. Radiance at the Sensor’s Aperture¶

Radiance is the “flux of energy (primarily irradiant or incident energy) per solid angle leaving a unit surface area in a given direction”, “Radiance is what is measured at the sensor and is somewhat dependent on reflectance” (NASA, 2011, p. 47).

Images such as Landsat or Sentinel-2 are composed of several bands and a metadata file which contains information required for the conversion to reflectance.

Landsat images are provided in radiance, scaled prior to output. for Landsat images Spectral Radiance at the sensor’s aperture (\(L_{\lambda}\), measured in [watts/(meter squared * ster * \(\mu m\))]) is given by (https://landsat.usgs.gov/Landsat8_Using_Product.php):

onde:

- \(M_{L}\) = Band-specific multiplicative rescaling factor from Landsat metadata (RADIANCE_MULT_BAND_x, where x is the band number)

- \(A_{L}\) = Band-specific additive rescaling factor from Landsat metadata (RADIANCE_ADD_BAND_x, where x is the band number)

- \(Q_{cal}\) = Quantized and calibrated standard product pixel values (DN)

Sentinel-2 images (Level-1C) are already provided in Top Of Atmosphere (TOA) Reflectance, scaled prior to output (ESA, 2015).

3.3.2. Top Of Atmosphere (TOA) Reflectance¶

Images in radiance can be converted to Top Of Atmosphere (TOA) Reflectance (combined surface and atmospheric reflectance) in order to reduce the in between-scene variability through a normalization for solar irradiance. This TOA reflectance (\(\rho_{p}\)), which is the unitless ratio of reflected versus total power energy (NASA, 2011), is calculated by:

onde:

- \(L_{\lambda}\) = Spectral radiance at the sensor’s aperture (at-satellite radiance)

- \(d\) = Earth-Sun distance in astronomical units (provided with Landsat 8 metadata file, and an excel file is available from http://landsathandbook.gsfc.nasa.gov/excel_docs/d.xls)

- \(ESUN_{\lambda}\) = Mean solar exo-atmospheric irradiances

- \(\theta_{s}\) = Solar zenith angle in degrees, which is equal to \(\theta_{s}\) = 90° - \(\theta_{e}\) where \(\theta_{e}\) is the Sun elevation

It is worth pointing out that Landsat 8 images are provided with band-specific rescaling factors that allow for the direct conversion from DN to TOA reflectance.

Sentinel-2 images are already provided in scaled TOA reflectance, which can be converted to TOA reflectance with a simple calculation using the Quantification Value provided in the metadata (see https://sentinel.esa.int/documents/247904/349490/S2_MSI_Product_Specification.pdf).

3.3.3. Surface Reflectance¶

The effects of the atmosphere (i.e. a disturbance on the reflectance that varies with the wavelength) should be considered in order to measure the reflectance at the ground.

As described by Moran et al. (1992), the land surface reflectance (\(\rho\)) is:

onde:

- \(L_{p}\) is the path radiance

- \(T_{v}\) is the atmospheric transmittance in the viewing direction

- \(T_{z}\) is the atmospheric transmittance in the illumination direction

- \(E_{down}\) is the downwelling diffuse irradiance

Therefore, we need several atmospheric measurements in order to calculate \(\rho\) (physically-based corrections). Alternatively, it is possible to use image-based techniques for the calculation of these parameters, without in-situ measurements during image acquisition. It is worth mentioning that Landsat Surface Reflectance High Level Data Products for Landsat 8 are available (for more information read http://landsat.usgs.gov/CDR_LSR.php).

3.3.4. DOS1 Correction¶

The Dark Object Subtraction (DOS) is a family of image-based atmospheric corrections. Chavez (1996) explains that “the basic assumption is that within the image some pixels are in complete shadow and their radiances received at the satellite are due to atmospheric scattering (path radiance). This assumption is combined with the fact that very few targets on the Earth’s surface are absolute black, so an assumed one-percent minimum reflectance is better than zero percent”. It is worth pointing out that the accuracy of image-based techniques is generally lower than physically-based corrections, but they are very useful when no atmospheric measurements are available as they can improve the estimation of land surface reflectance. The path radiance is given by (Sobrino, et al., 2004):

onde:

- \(L_{min}\) = “radiance that corresponds to a digital count value for which the sum of all the pixels with digital counts lower or equal to this value is equal to the 0.01% of all the pixels from the image considered” (Sobrino, et al., 2004, p. 437), therefore the radiance obtained with that digital count value (\(DN_{min}\))

- \(L_{DO1\%}\) = radiance of Dark Object, assumed to have a reflectance value of 0.01

In particular for Landsat images:

Sentinel-2 images are converted to radiance prior to DOS1 calculation.

The radiance of Dark Object is given by (Sobrino, et al., 2004):

Therefore the path radiance is:

There are several DOS techniques (e.g. DOS1, DOS2, DOS3, DOS4), based on different assumption about \(T_{v}\), \(T_{z}\) , and \(E_{down}\) . The simplest technique is the DOS1, where the following assumptions are made (Moran et al., 1992):

- \(T_{v}\) = 1

- \(T_{z}\) = 1

- \(E_{down}\) = 0

Therefore the path radiance is:

And the resulting land surface reflectance is given by:

ESUN [W /(m2 * \(\mu m\))] values for Landsat sensors are provided in the following table.

ESUN values for Landsat bands

| Band | Landsat 1 MSS* | Landsat 2 MSS* | Landsat 3 MSS* | Landsat 4 TM* | Landsat 5 TM* | Landsat 7 ETM+** |

|---|---|---|---|---|---|---|

| 1 | 1983 | 1983 | 1970 | |||

| 2 | 1795 | 1796 | 1842 | |||

| 3 | 1539 | 1536 | 1547 | |||

| 4 | 1823 | 1829 | 1839 | 1028 | 1031 | 1044 |

| 5 | 1559 | 1539 | 1555 | 219.8 | 220 | 225.7 |

| 6 | 1276 | 1268 | 1291 | |||

| 7 | 880.1 | 886.6 | 887.9 | 83.49 | 83.44 | 82.06 |

| 8 | 1369 |

* from Chander, Markham, & Helder (2009)

** from http://landsathandbook.gsfc.nasa.gov/data_prod/prog_sect11_3.html

For Landsat 8, \(ESUN\) can be calculated as (from http://grass.osgeo.org/grass65/manuals/i.landsat.toar.html):

where RADIANCE_MAXIMUM and REFLECTANCE_MAXIMUM are provided by image metadata.

ESUN [W /(m2 * \(\mu m\))] values for Sentinel-2 sensor (provided in image metadata) are illustrated in the following table.

ESUN values for Sentinel-2 bands

| Band | Sentinel-2 |

|---|---|

| 1 | 1913.57 |

| 2 | 1941.63 |

| 3 | 1822.61 |

| 4 | 1512.79 |

| 5 | 1425.56 |

| 6 | 1288.32 |

| 7 | 1163.19 |

| 8 | 1036.39 |

| 8A | 955.19 |

| 9 | 813.04 |

| 10 | 367.15 |

| 11 | 245.59 |

| 12 | 85.25 |

ESUN [W /(m2 * \(\mu m\))] values for ASTER sensor are illustrated in the following table (from Finn, et al., 2012).

ESUN values for ASTER bands

| Band | ASTER |

|---|---|

| 1 | 1848 |

| 2 | 1549 |

| 3 | 1114 |

| 4 | 225.4 |

| 5 | 86.63 |

| 6 | 81.85 |

| 7 | 74.85 |

| 8 | 66.49 |

| 9 | 59.85 |

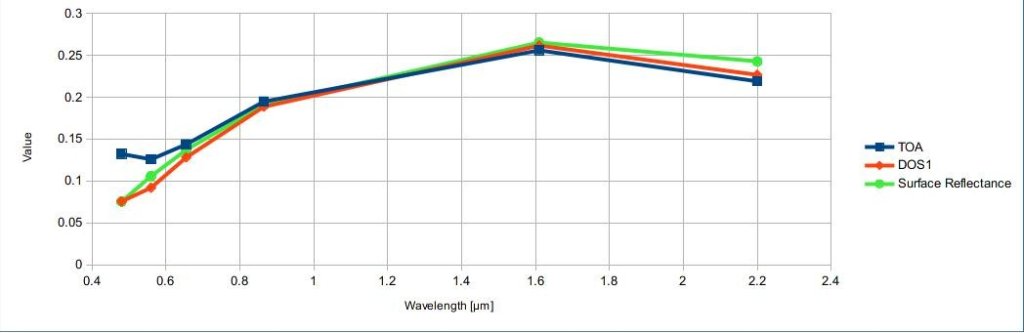

An example of comparison of to TOA reflectance, DOS1 corrected reflectance and the Landsat Surface Reflectance High Level Data Products (ground truth) is provided in Figure Spectral signatures of a built-up pixel.

Spectral signatures of a built-up pixel

Comparison of TOA reflectance, DOS1 corrected reflectance and Landsat Surface Reflectance High Level Data Products3.4. Conversion to Temperature¶

This chapter provides the basic information about the conversion to At-Satellite Brightness Temperature implemented in SCP and the estimation of Land Surface Temperature.

3.4.1. Conversion to At-Satellite Brightness Temperature¶

For thermal bands, the conversion of DN to At-Satellite Brightness Temperature is given by (from https://landsat.usgs.gov/Landsat8_Using_Product.php):

onde:

- \(K_{1}\) = Band-specific thermal conversion constant (in watts/meter squared * ster * \(\mu m\))

- \(K_{2}\) = Band-specific thermal conversion constant (in kelvin)

and \(L_{\lambda}\) is the Spectral Radiance at the sensor’s aperture, measured in watts/(meter squared * ster * \(\mu m\)).

The \(K_{1}\) and \(K_{2}\) constants for Landsat sensors are provided in the following table.

Thermal Conversion Constants for Landsat

| Constant | Landsat 4* | Landsat 5* | Landsat 7** |

|---|---|---|---|

| \(K_{1}\) | 671.62 | 607.76 | 666.09 |

| \(K_{2}\) | 1284.30 | 1260.56 | 1282.71 |

* from Chander & Markham (2003)

** from NASA (2011)

For Landsat 8, the \(K_{1}\) and \(K_{2}\) values are provided in the image metadata file.

\(K_{1}\) and \(K_{2}\) are calculated as (Jimenez-Munoz & Sobrino, 2010):

where (Mohr, Newell, & Taylor, 2015):

- \(c_{1}\) = first radiation constant = \(1.191 * 10^{-16} W m^{2} sr^{-1}\)

- \(c_{2}\) = second radiation constant = \(1.4388 * 10^{-2} m K\)

Therefore, for ASTER bands \(K_{1}\) and \(K_{2}\) are provided in the following table.

Thermal Conversion Constants for ASTER

| Constant | Band 10 | Band 11 | Band 12 | Band 13 | Band 14 |

|---|---|---|---|---|---|

| \(K_{1}\) | \(3.024 * 10^{3}\) | \(2.460 * 10^{3}\) | \(1.909 * 10^{3}\) | \(8.900 * 10^{2}\) | \(6.464 * 10^{2}\) |

| \(K_{2}\) | \(1.733 * 10^{3}\) | \(1.663 * 10^{3}\) | \(1.581 * 10^{3}\) | \(1.357 * 10^{3}\) | \(1.273 * 10^{3}\) |

3.4.2. Estimation of Land Surface Temperature¶

Several studies have described the estimation of Land Surface Temperature. Land Surface Temperature can be calculated from At-Satellite Brightness Temperature \(T_{B}\) as (Weng, et al. 2004):

onde:

- \(\lambda\) = wavelength of emitted radiance

- \(c_{2} = h * c / s = 1.4388 * 10^{-2}\) m K

- \(h\) = Planck’s constant = \(6.626 * 10^{-34}\) J s

- \(s\) = Boltzmann constant = \(1.38 * 10^{-23}\) J/K

- \(c\) = velocity of light = \(2.998 * 10^{8}\) m/s

The values of \(\lambda\) for the thermal bands of Landsat and ASTER satellites can be calculated from the tables in Satélites Landsat and ASTER Satellite.

Several studies used NDVI for the estimation of land surface emissivity (Sobrino, et al., 2004); other studies used a land cover classification for the definition of the land surface emissivity of each class (Weng, et al. 2004). For instance, the emissivity (\(e\)) values of various land cover types are provided in the following table (from Mallick, et al. 2012).

Emissivity values

| Land surface | Emissivity e |

|---|---|

| Soil | 0.928 |

Erva |

0.982 |

| Asphalt | 0.942 |

| Concrete | 0.937 |

3.5. References¶

- Chander, G. & Markham, B. 2003. Revised Landsat-5 TM radiometric calibration procedures and postcalibration dynamic ranges Geoscience and Remote Sensing, IEEE Transactions on, 41, 2674 - 2677

- Chavez, P. S. 1996. Image-Based Atmospheric Corrections - Revisited and Improved Photogrammetric Engineering and Remote Sensing, [Falls Church, Va.] American Society of Photogrammetry, 62, 1025-1036

- Congalton, R. and Green, K., 2009. Assessing the Accuracy of Remotely Sensed Data: Principles and Practices. Boca Raton, FL: CRC Press

- Didan, K.; Barreto Munoz, A.; Solano, R. & Huete, A. 2015. MODIS Vegetation Index User’s Guide. Collection 6, NASA

- ESA, 2015. Sentinel-2 User Handbook. Available at https://sentinel.esa.int/documents/247904/685211/Sentinel-2_User_Handbook

- Finn, M.P., Reed, M.D, and Yamamoto, K.H. 2012. A Straight Forward Guide for Processing Radiance and Reflectance for EO-1 ALI, Landsat 5 TM, Landsat 7 ETM+, and ASTER. Unpublished Report from USGS/Center of Excellence for Geospatial Information Science, 8 p, http://cegis.usgs.gov/soil_moisture/pdf/A%20Straight%20Forward%20guide%20for%20Processing%20Radiance%20and%20Reflectance_V_24Jul12.pdf

- Fisher, P. F. and Unwin, D. J., eds. 2005. Representing GIS. Chichester, England: John Wiley & Sons

- JARS, 1993. Remote Sensing Note. Japan Association on Remote Sensing. Available at http://www.jars1974.net/pdf/rsnote_e.html

- Jimenez-Munoz, J. C. & Sobrino, J. A. 2010. A Single-Channel Algorithm for Land-Surface Temperature Retrieval From ASTER Data IEEE Geoscience and Remote Sensing Letters, 7, 176-179

Johnson, B. A., Tateishi, R. and Hoan, N. T., 2012. Satellite Image Pansharpening Using a Hybrid Approach for Object-Based Image Analysis ISPRS International Journal of Geo-Information, 1, 228. Available at http://www.mdpi.com/2220-9964/1/3/228)

- Kruse, F. A., et al., 1993. The Spectral Image Processing System (SIPS) - Interactive Visualization and Analysis of Imaging spectrometer. Data Remote Sensing of Environment

- Mallick, J.; Singh, C. K.; Shashtri, S.; Rahman, A. & Mukherjee, S. 2012. Land surface emissivity retrieval based on moisture index from LANDSAT TM satellite data over heterogeneous surfaces of Delhi city International Journal of Applied Earth Observation and Geoinformation, 19, 348 - 358

- Mohr, P. J.; Newell, D. B. & Taylor, B. N. 2015. CODATA Recommended Values of the Fundamental Physical Constants: 2014 National Institute of Standards and Technology, Committee on Data for Science and Technology

- Moran, M.; Jackson, R.; Slater, P. & Teillet, P. 1992. Evaluation of simplified procedures for retrieval of land surface reflectance factors from satellite sensor output Remote Sensing of Environment, 41, 169-184

- NASA (Ed.) 2011. Landsat 7 Science Data Users Handbook Landsat Project Science Office at NASA’s Goddard Space Flight Center in Greenbelt, 186 http://landsathandbook.gsfc.nasa.gov/pdfs/Landsat7_Handbook.pdf

- NASA, 2013. Landsat 7 Science Data User’s Handbook. Available at http://landsathandbook.gsfc.nasa.gov

- Ready, P. and Wintz, P., 1973. Information Extraction, SNR Improvement, and Data Compression in Multispectral Imagery. IEEE Transactions on Communications, 21, 1123-1131

- Richards, J. A. and Jia, X., 2006. Remote Sensing Digital Image Analysis: An Introduction. Berlin, Germany: Springer.

- Sobrino, J.; Jiménez-Muñoz, J. C. & Paolini, L. 2004. Land surface temperature retrieval from LANDSAT TM 5 Remote Sensing of Environment, Elsevier, 90, 434-440

- USGS, 2015. Advanced Spaceborne Thermal Emission and Reflection Radiometer (ASTER) Level 1 Precision Terrain Corrected Registered At-Sensor Radiance Product (AST_L1T). AST_L1T Product User’s Guide. USGS EROS Data Center.

- Vermote, E. F.; Roger, J. C. & Ray, J. P. 2015. MODIS Surface Reflectance User’s Guide. Collection 6, NASA

- Weng, Q.; Lu, D. & Schubring, J. 2004. Estimation of land surface temperature–vegetation abundance relationship for urban heat island studies. Remote Sensing of Environment, Elsevier Science Inc., Box 882 New York NY 10159 USA, 89, 467-483