3. Breve Introducción a la Teledetección¶

3.1. Definiciones Básicas¶

Este capítulo proporciona definiciones básicas sobre SIG y teledetección. Para otros recursos útiles mira Recursos gratis y valiosos sobre teledetección y SIG.

3.1.1. Definición de SIG¶

Existen muchas definiciones de SIG (Sistemas de Información Geográfica) que no es simplemente un programa. En general los SIG son sistemas que permiten el uso de información geográfica (los datos tienen coordenadas espaciales). En particular, los SIG permiten ver, consultar, calcular y realizar análisis espaciales de los datos, que principalmente son de tipo ráster y vectorial. Los datos vectoriales están formados por objetos que pueden ser puntos, líneas y polígonos; cada objeto puede tener uno o más atributos con valores. Un ráster es una cuadrícula (o imagen) en la que cada celda tiene un atributo con valores (Fisher and Unwin, 2005). Muchas aplicaciones SIG utilizan imágenes ráster que son obtenidas con sensores remotos.

3.1.2. Definición de Teledetección¶

Una definición general de Teledetección es “la ciencia y la tecnología por medio de la cual las características de los objetos de interés pueden ser identificados, medidos o se pueden analizar sus características sin contacto directo” (JARS, 1993).

Normalmente, la teledetección es la medición de la energía que es emanada desde la superficie de la Tierra. Si la fuente de la energía medida es el Sol, entonces es llamada teledetección pasiva, y el resultado de esta medición puede ser una imagen digital (Richards and Jia, 2006). Si la energía medida no es emitida por el Sol y es emitida desde el sensor de la plataforma es definida como teledetección activa, como los sensores de radar que trabajan en el rango de las microondas (Richards and Jia, 2006).

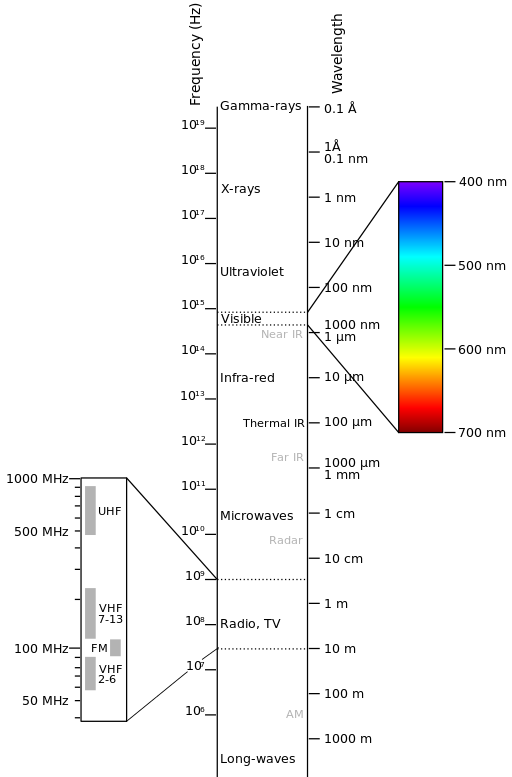

El espectro electromagnético es “el sistema que clasifica, según las longitudes de onda, toda la energía (desde onda corta cósmica hasta onda larga de radio) que se mueve, armónicamente, a la velocidad constante de la luz” (NASA, 2013). Los sensores pasivos miden la energía en la región óptica del espectro electromagnético, que incluye el visible, infrarrojo cercano (i.e. IR), infrarrojo medio SWIR, y el infrarrojo térmico (ver Figura Espectro Electromagnético).

Espectro Electromagnético

by Victor Blacus (SVG version of File:Electromagnetic-Spectrum.png)

[CC-BY-SA-3.0 (http://creativecommons.org/licenses/by-sa/3.0)]

via Wikimedia Commons

http://commons.wikimedia.org/wiki/File%3AElectromagnetic-Spectrum.svg

La interacción entre la energía solar y los materiales depende de la longitud de onda. La energía llega desde desde el Sol hasta la Tierra y de ahí hacia el sensor. A lo largo de esta trayectoria, la energía solar atraviesa varios medios y puede ser (NASA, 2013):

Transmitida - La energía atraviesa de un medio a otro con un cambio en su velocidad determinado por el índice de refracción de los dos medios.

Absorbida - La energía se incorpora a la estructura molecular del material.

Reflejada - La energía regresar sin cambio con un ángulo de reflexión igual al ángulo de incidencia. La reflectancia es la proporción de energía reflejada con respecto a la energía incidente en un cuerpo. La longitud de onda reflejada (no la absorbida) determina el color de un objeto.

Dispersada - La dirección de propagación de la energía cambia aleatoriamente. La dispersión de Rayleigh y la de dispersión de Mie son los dos tipos más importantes de dispersión que ocurren en la atmósfera.

Emitida - De hecho, la energía es primero absorbida y luego re-emitida, generalmente con una longitud de onda mayor. El objeto se calienta.

3.1.3. Sensores¶

Los Sensores pueden estar a bordo de aeroplanos o de satélites, midiendo la radiación electromagnética en rangos específicos (normalmente llamadas bandas). Como resultado, las mediciones son cuantificadas y convertidas en una imagen digital, donde cada elemento de la imagen (i.e. pixel) tiene un valor discreto en unidades de Digital Number (DN) (NASA, 2013). Las imágenes resultantes tienen diferentes características (resoluciones) dependiendo del sensor. Existen diferentes tipos de resoluciones:

Resolución Espacial, normalmente media en tamaño de pixel, “es el poder de resolución que necesita un instrumento para la discriminación de entidades y está basada en el tamaño del detector, longitud focal, y la altitud del sensor” (NASA, 2013); la resolución espacial es también denominada resolución geométrica o IFOV;

Resolución Espectral, es el número y localización en el espectro electromagnético (definido por dos longitudes de onda) de la banda espectral (NASA, 2013) en sensores multiespectrales, para cada banda corresponde una imagen;

Resolución Radiométrica, normalmente medida en bits (dígitos binarios), es el rango de valores de brillo disponibles, los cuales en la imagen corresponden al máximo rango de DNs; por ejemplo una imagen con 8 bit de resolución tiene 256 niveles de brillo (Richards and Jia, 2006);

Para sensores satelitales, existe también la resolución temporal, que es el tiempo requerido para la revisita de la misma área de la Tierra (NASA, 2013).

3.1.4. Radiancia y Reflectancia¶

Los sensores miden la radiancia, la cual corresponde a la energía enviada en una dirección dada hacia el sensor; es también útil definir la reflectancia como la relación entre la reflejada contra la potencia total de energía.

3.1.5. Firma Espectral¶

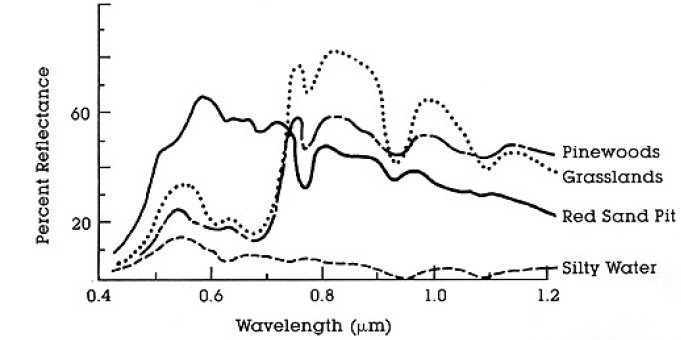

La firma espectral es la reflectancia en función de la longitud de onda (mira Figura Curvas de Reflectancia Espectral de Cuatro Objetivos); cada material tiene una firma única, por lo tanto puede ser usada para la clasificación de materiales (NASA, 2013).

Curvas de Reflectancia Espectral de Cuatro Objetivos

(desde NASA, 2013)

3.1.6. Satélite Landsat¶

Landsat es un conjunto de satélites desarrollados por la NASA (National Aeronautics and Space Administration of USA), desde comienzos de los 1970’s.

Las imágenes Landsat son muy utilizadas para la investigación ambiental. Las resoluciones de los sensores Landsat 4 y Landsat 5 se presentan en la siguiente tabla (desde http://landsat.usgs.gov/band_designations_landsat_satellites.php); además, la resolución temporal de Landsat es de 16 días (NASA, 2013).

Bandas Landsat 4 y Landsat 5

Bandas Landsat 4, Landsat 5 |

Longitud de Onda [micrómetros] |

Resolución [metros] |

|---|---|---|

Banda 1 - Azul |

0.45 - 0.52 | 30 |

Banda 2 - Verde |

0.52 - 0.60 | 30 |

Banda 3 - Rojo |

0.63 - 0.69 | 30 |

Banda 4 - Infrarrojo Cercano (NIR) |

0.76 - 0.90 | 30 |

Banda 5 - SWIR |

1.55 - 1.75 | 30 |

Banda 6 - Infrarrojo Térmico |

10.40 - 12.50 | 120 (remuestreada a 30) |

Banda 7 - SWIR |

2.08 - 2.35 | 30 |

Las resoluciones del sensor Landsat 7 se presentan en la siguiente tabla (desde http://landsat.usgs.gov/band_designations_landsat_satellites.php); además, la resolución temporal de Landsat es de 16 días (NASA, 2013).

Bandas Landsat 7

Bandas Landsat 7 |

Longitud de Onda [micrómetros] |

Resolución [metros] |

|---|---|---|

Banda 1 - Azul |

0.45 - 0.52 | 30 |

Banda 2 - Verde |

0.52 - 0.60 | 30 |

Banda 3 - Rojo |

0.63 - 0.69 | 30 |

Banda 4 - Infrarrojo Cercano (NIR) |

0.77 - 0.90 | 30 |

Banda 5 - SWIR |

1.57 - 1.75 | 30 |

Banda 6 - Infrarrojo Térmico |

10.40 - 12.50 | 60 (remuestrada a 30) |

Banda 7 - SWIR |

2.09 - 2.35 | 30 |

Banda 8 - Pancromática |

0.52 - 0.90 | 15 |

Las resoluciones del sensor Landsat 8 se presentan en la siguiente tabla (desde http://landsat.usgs.gov/band_designations_landsat_satellites.php); además, la resolución temporal de Landsat es de 16 días (NASA, 2013).

Bandas Landsat 8

Bandas Landsat 8 |

Longitud de Onda [micrómetros] |

Resolución [metros] |

|---|---|---|

Banda 1 - Coastal aerosol |

0.43 - 0.45 | 30 |

Banda 2 - Azul |

0.45 - 0.51 | 30 |

Banda 3 - Verde |

0.53 - 0.59 | 30 |

Banda 4 - Rojo |

0.64 - 0.67 | 30 |

Banda 5 - Infrarrojo Cercano (NIR) |

0.85 - 0.88 | 30 |

Banda 6 - SWIR 1 |

1.57 - 1.65 | 30 |

Banda 7 - SWIR 2 |

2.11 - 2.29 | 30 |

Banda 8 - Pancromática |

0.50 - 0.68 | 15 |

Banda 9 - Cirrus |

1.36 - 1.38 | 30 |

Banda 10 - Infrarrojo Térmico (TIRS) 1 |

10.60 - 11.19 | 100 (remuestreada a 30) |

Banda 11 - Infrarrojo Térmico (TIRS) 2 |

11.50 - 12.51 | 100 (remuestreada a 30) |

A vast archive of images is freely available from the U.S. Geological Survey . For more information about how to freely download Landsat images read this .

Las imágenes están identificadas por sus paths y rows del WRS (Worldwide Reference System for Landsat ).

3.1.7. Satélite Sentinel-2¶

Sentinel-2 es un satélite multiespectral desarrollado por la European Space Agency (ESA) en el marco del Copernicus land monitoring services. Sentinel-2 adquiere 13 bandas espectrales con resolución espectral de 10m, 20m y 60m dependiendo de la banda, como se ilustra en la siguiente tabla (ESA, 2015).

Bandas Sentinel-2

Bandas Sentinel-2 |

Longitud de Onda Central [micrómetros] |

Resolución [metros] |

|---|---|---|

Banda 1 - Coastal aerosol |

0.443 | 60 |

Banda 2 - Azul |

0.490 | 10 |

Banda 3 - Verde |

0.560 | 10 |

Banda 4 - Rojo |

0.665 | 10 |

Banda 5 - Vegetation Red Edge |

0.705 | 20 |

Banda 6 - Vegetation Red Edge |

0.740 | 20 |

Banda 7 - Vegetation Red Edge |

0.783 | 20 |

Banda 8 - NIR |

0.842 | 10 |

Banda 8A - Vegetation Red Edge |

0.865 | 20 |

Banda 9 - Water vapour |

0.945 | 60 |

Banda 10 - SWIR - Cirrus |

1.375 | 60 |

Banda 11 - SWIR |

1.610 | 20 |

Banda 12 - SWIR |

2.190 | 20 |

Las imágenes Sentinel-2 están disponibles gratuitamente desde el sitio web de la ESA https://scihub.esa.int/dhus/ .

3.1.8. Satélite ASTER¶

El satélite ASTER (Advanced Spaceborne Thermal Emission and Reflection Radiometer) fue lanzado en 1999 por la colaboración entre el Japanese Ministry of International Trade and Industry (MITI) y la NASA. ASTER tiene 14 bandas cuyas resoluciones espaciales varían con las longitudes de onda: 15m en el visible e infrarrojo cercano, 30m en el infrarrojo medio, y 90m en el infrarrojo térmico (USGS, 2015). Las bandas ASTER son presentadas en la siguiente tabla (debido a una falla del sensor los datos SWIR adquiridos desde Abril 1, 2008 no están disponibles ). La banda adicional 3B (backwardlooking near-infrared) proporciona una cobertura stereo.

Bandas ASTER

Bandas ASTER |

Longitud de Onda [micrómetros] |

Resolución [metros] |

|---|---|---|

Banda 1 - Verde |

0.52 - 0.60 | 15 |

Banda 2 - Rojo |

0.63 - 0.69 | 15 |

Banda 3N - Infrarrojo Cercano (NIR) |

0.78 - 0.86 | 15 |

Banda 4 - SWIR 1 |

1.60 - 1.70 | 30 |

Banda 5 - SWIR 2 |

2.145 - 2.185 | 30 |

Banda 6 - SWIR 3 |

2.185 - 2.225 | 30 |

Banda 7 - SWIR 4 |

2.235 - 2.285 | 30 |

Banda 8 - SWIR 5 |

2.295 - 2.365 | 30 |

Banda 9 - SWIR 6 |

2.360 - 2.430 | 30 |

Banda 10 - TIR 1 |

8.125 - 8.475 | 90 |

Banda 11 - TIR 2 |

8.475 - 8.825 | 90 |

Banda 12 - TIR 3 |

8.925 - 9.275 | 90 |

Banda 13 - TIR 4 |

10.25 - 10.95 | 90 |

Banda 14 - TIR 5 |

10.95 - 11.65 | 90 |

3.1.9. MODIS Products¶

The MODIS (Moderate Resolution Imaging Spectroradiometer) is an instrument operating on the Terra and Aqua satellites launched by NASA in 1999 and 2002 respectively. Its temporal resolutions allows for viewing the entire Earth surface every one to two days, with a swath width of 2,330. Its sensors measure 36 spectral bands at three spatial resolutions: 250m, 500m, and 1,000m (see https://lpdaac.usgs.gov/dataset_discovery/modis).

Several products are available, such as surface reflectance and vegetation indices. In this manual we are considering the surface reflectance bands available at 250m and 500m spatial resolution (Vermote, Roger, & Ray, 2015).

MODIS Bands

| MODIS Bands | Longitud de Onda [micrómetros] |

Resolución [metros] |

|---|---|---|

| Band 1 - Red | 0.62 - 0.67 | 250 - 500 |

| Band 2 - Near Infrared (NIR) | 0.841 - 0.876 | 250 - 500 |

| Band 3 - Blue | 0.459 - 0.479 | 500 |

| Band 4 - Green | 0.545 - 0.565 | 500 |

| Band 5 - SWIR 1 | 1.230 - 1.250 | 500 |

| Band 6 - SWIR 2 | 1.628 - 1.652 | 500 |

| Band 7 - SWIR 3 | 2.105 - 2.155 | 500 |

The following products (Version 6, see https://lpdaac.usgs.gov/dataset_discovery/modis/modis_products_table) are available for download (Vermote, Roger, & Ray, 2015):

- MOD09GQ: daily reflectance at 250m spatial resolution from Terra MODIS;

- MYD09GQ: daily reflectance at 250m spatial resolution from Aqua MODIS;

- MOD09GA: daily reflectance at 500m spatial resolution from Terra MODIS;

- MYD09GA: daily reflectance at 500m spatial resolution from Aqua MODIS;

- MOD09Q1: reflectance at 250m spatial resolution, which is a composite of MOD09GQ (each pixel contains the best possible observation during an 8-day period);

- MYD09Q1: reflectance at 250m spatial resolution, which is a composite of MYD09GQ (each pixel contains the best possible observation during an 8-day period);

- MOD09A1: reflectance at 250m spatial resolution, which is a composite of MOD09GA (each pixel contains the best possible observation during an 8-day period);

- MYD09A1: reflectance at 250m spatial resolution, which is a composite of MYD09GA (each pixel contains the best possible observation during an 8-day period);

3.1.10. Composición de Color¶

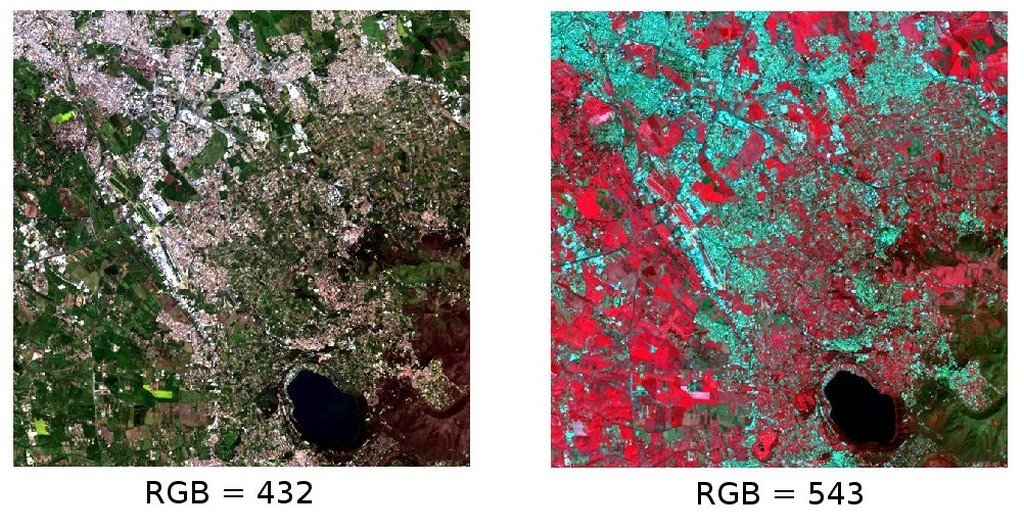

A menudo se crea una combinación de tres imágenes individuales monocromáticas, en la cual cada una es asignada a un color. Esto es conocido como una composición de color y es útil para interpretación visual (NASA, 2013). Las composiciones de color son generalmente expresadas como:

“R G B = Br Bg Bb”

donde:

R significa Rojo;

G significa Verde;

B significa Azul;

Br es el número de banda asociada al color Rojo;

Bg es el número de banda asociada al color Verde;

Bb es el número de banda asociada al color Azul;

La siguiente figura Composición de color para una imagen Landsat 8 muestra una composición de color “R G B = 4 3 2” de una imagen Landsat 8 (para Landsat 7 la misma composición de color es “R G B = 3 2 1, mientras que para Sentinel-2 es R G B = 4 3 2) y una composición de color “R G B = 5 4 3” (para Landsat 7 la misma composición de color es “R G B = 4 3 2, mientras que para Sentinel-2 es R G B = 8 4 3). La composición “R G B = 5 4 3” es útil para la interpretación de la imagen debido a que los píxeles de vegetación se muestran en colores rojos (la vegetación saludable refleja una gran parte de la luz incidente en la longitud de onda del infrarrojo cercano, resultando en valores de reflectancias más altos para la banda 5, dando por lo tanto valores más altos al rojo).

Composición de color para una imagen Landsat 8

Datos onbtenidos de U.S. Geological Survey

3.1.11. Análisis de Componentes Principales¶

El Análisis de Componentes Principales (ACP) es un método para reducir la dimensionalidad de un conjunto de variables medidas (bandas) en sus componentes principales (JARS, 1993)

La transformación de componentes principales produce un nuevo conjunto de bandas (componentes principales) con las siguientes características: Los componentes principales no están correlacionados; cada componente tiene una varianza menor al componente previo. Por lo tanto, éste es un método eficiente para la extracción de información y comprensión de datos (Ready and Wintz, 1973).

Dada una imagen con N bandas espectrales, los componentes principales se obtienen por cálculo matricial (Ready and Wintz, 1973; Richards and Jia, 2006):

donde:

\(Y\) = vector de componentes principales

\(D\) = matriz de autovalores de la matriz de covarianza \(C_x\) en el espacio X

\(t\) denota la transposición vectorial

Y \(X\) se calcula de la siguiente manera:

\(P\) = vector de valores espectrales asociados a cada píxel.

\(M\) = vector de la media asociada a cada banda

Por lo tanto, la media de \(X\) asociada a cada banda es 0. \(D\) está formado por los autovectores (de la matriz de covarianza \(C_x\)) ordenados de valores máximos a mínimos de los autovalores, para así tener el máximo de varianza en el primer componente. De esta forma, los componentes principales no están correlacionados unos con otros, y cada componente tiene una varianza menor que el anterior (Ready and Wintz, 1973).

Usualmente, los dos primeros componentes contienen más del 90% de la varianza. Por ejemplo, el primer componente principal puede ser visualizado en una Composición de Color para resaltar las clases de una Cobertura del suelo, o utilizadas como entrada para una Clasificación supervisada.

3.1.12. Pan-sharpening¶

Pan-sharpening se refiere a la combinación de la información de las bandas multiespectrales (MS), las cuales tienen una menor resolución espacial (para Landsat, las bandas tienen una resolución espacial de 30m), con la resolución espacial de una banda pancromática (PAN), que para Landsat 7 y 8 es de 15m. El resultado es una imagen multiespectral con la resolución espacial de la banda pancromática (ej. 15m). En SCP, se aplica una transformación de Brovey, en la cual los valores de cada banda multiespectral con la nueva resolución se calculan de la siguiente manera (Johnson, Tateishi and Hoan, 2012):

Donde \(I\) es Intensidad, la cual es una función de las bandas multiespectrales.

Se definen los siguientes pesos para I, en base a varias pruebas utilizando el SCP. Para Landsat 8, la Intensidad es calculada como:

Para Landsat 7, la Intensidad es calculada de la siguiente manera:

ejemplo de pan-sharpening de una imagen Landsat 8. Izquierda, bandas originales multiespectrales (30m); derecha, bandas con nueva resolución (pan-sharpened, 15m)

Datos onbtenidos de U.S. Geological Survey

3.1.13. Spectral Indices¶

Spectral indices are operations between spectral bands that are useful for extracting information such as vegetation cover (JARS, 1993). One of the most popular spectral indices is the Normalized Difference Vegetation Index (NDVI), defined as (JARS, 1993):

NDVI values range from -1 to 1. Dense and healthy vegetation show higher values, while non-vegetated areas show low NDVI values.

Another index is the Enhanced Vegetation Index (EVI) which attempts to account for atmospheric effects such as path radiance calculating the difference between the blue and the red bands (Didan,et al., 2015). EVI is defined as:

where: \(G\) is a scaling factor, \(C_1\) and \(C_2\) are coefficients for the atmospheric effects, and \(L\) is a factor for accounting the differential NIR and Red radiant transfer through the canopy. Typical coefficient values are: \(G = 2.5\), \(L = 1\), \(C_1 = 6\), \(C_2 = 7.5\) (Didan,et al., 2015).

3.2. Definiciones sobre Clasificación Supervisada¶

Este capítulo ofrece definiciones básicas acerca de clasificación supervisada.

3.2.1. Cobertura del suelo¶

La Cobertura del suelo es el material en la superficie terrestre, tal como tierra, vegetación, agua, asfalto, etc. (Fisher and Unwin, 2005). Dependiendo de las resoluciones del sensor, el número y tipo de clases coberturas del suelo que pueden ser identificadas en una imagen pueden variar significativamente.

3.2.2. Clasificación supervisada¶

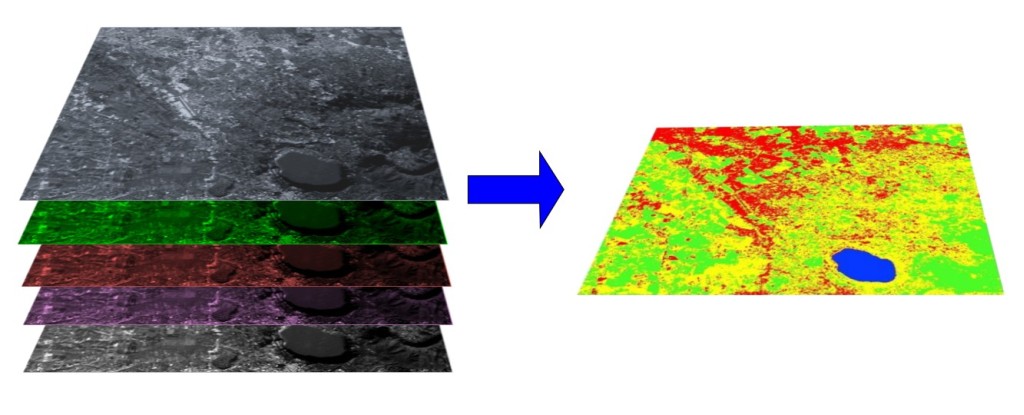

Una clasificación semi-automática (también llamada una clasificación supervisada) es una técnica de procesamiento de imágenes que permite la identificación de materiales en una imagen a partir de sus firmas espectrales. Existen varios tipos de algoritmos de clasificación, pero el propósito general es producir un mapa temático de la cobertura del suelo.

El procesamiento de imágenes y el análisis espacial con SIG requieren de software específico, tal como el Semi-Automatic Classification Plugin de QGIS.

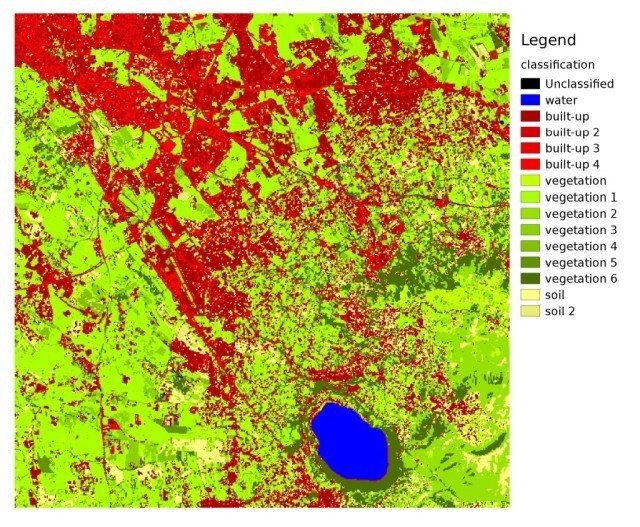

Imagen multiespectral procesada para producir una clasificación de la cobertura del suelo

(Imagen Landsat proporcionada por USGS)

3.2.3. Áreas de entrenamiento¶

Usualmente, la clasificación supervisada requiere que el usuario seleccione una o más Regiones de Interés (ROIs, o Áreas de Entrenamiento) para cada clase de cobertura del suelo identificada en la imagen. Las ROIs son polígonos dibujados sobre áreas homogéneas de la imagen que se superponen a píxeles pertenecientes a la misma clase de cobertura del suelo.

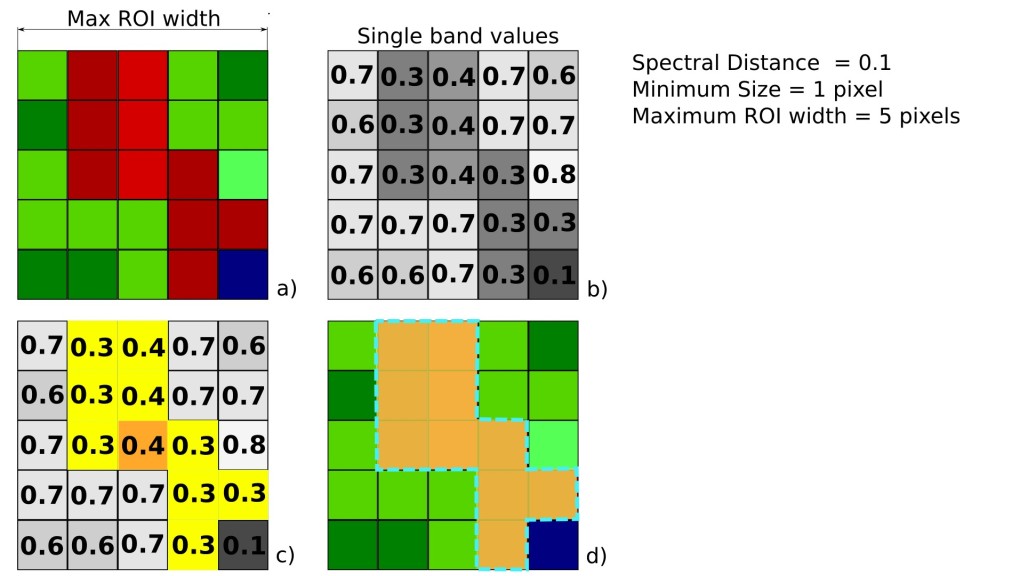

3.2.3.1. Algoritmo de Región Incremental¶

El Algoritmo de Región Incremental permite seleccionar los pixeles similares a un pixel semilla, considerando la similitud espectral (es decir, la distancia espectral) de los pixeles adyacentes. En SCP, el Algoritmo de Región Incremental está disponible para la creación de áreas de entrenamiento. El parámetro distancia está relacionado a la similitud de los valores de los pixeles al pixel semilla (mientras más bajo el valor, más similares serán los pixeles seleccionados). Un parámetro adicional es el ancho máximo, el cual es el lado de un cuadrado, centrado en el pixel semilla, el cual inscribe el área de entrenamiento (si todos los pixeles tuviesen el mismo valor, el área de entrenamiento sería este cuadrado). El tamaño mínimo es utilizado como restricción (para cada banda), seleccionando al menos los pixeles que son más similares al pixel semilla hasta que el número de pixeles seleccionados sean iguales al tamaño mínimo.

En la figura Ejemplo de Región Incremental el pixel central es usado como semilla (imagen a), para la región incremental de una banda (imagen b) con el parámetro distancia espectral = 0.1; los pixeles similares son seleccionados para crear el área de entrenamiento (imagen c, e imagen d).

Ejemplo de Región Incremental

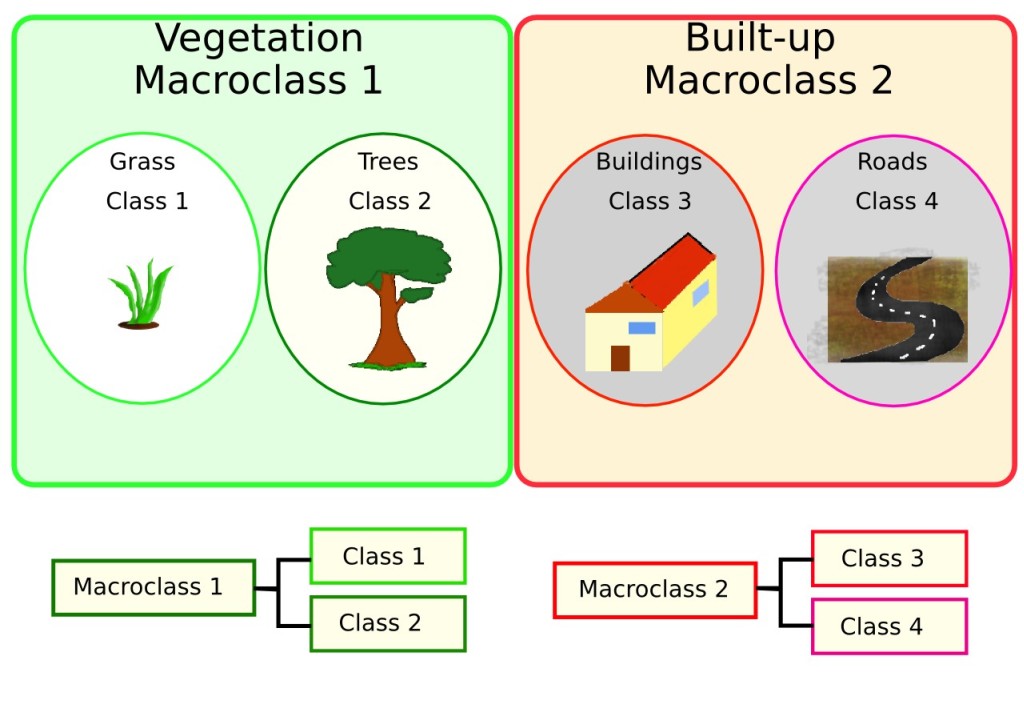

3.2.4. Clases y Macroclases¶

Las clases de cobertura del suelo se identifican con un código ID arbitrario (identificador). SCP permite la definición de Macroclase ID (MC ID), y Clase ID ** (C ID), los cuales son los códigos de identificador de las clases de cobertura del suelo. Una **Macroclase es un grupo de ROIs con diferente ID Clase, lo cual es útil cuando se necesita clasificar materiales que tienen diferente firma espectral en la misma clase de cobertura. Por ejemplo, es posible identificar pasto (e.g. Clase ID = 1 y Macroclase ID = 1 ) y árboles (ej. Clase ID = 2 y Macroclase ID = 1 ) como clase vegetación (ej. Macroclase ID = 1 ). Varios Clase IDs pueden ser asignados al mismo Macroclase ID, pero el mismo Clase ID no puede ser asignado a diferentes Macroclase IDs, tal como se muestra en la siguiente tabla:

Ejemplo de Macroclases

Nombre de la Macroclase |

Macroclase ID |

Nombre de clase |

Clase ID |

|---|---|---|---|

Vegetación |

1 | Pasto |

1 |

Vegetación |

1 | Árboles |

2 |

Construcciones |

2 | Construcciones |

3 |

Construcciones |

2 | Caminos |

4 |

Por lo tanto, las Clases son subconjuntos de una Macroclase, como se muestra en la Figura Ejemplo de Macroclases.

Ejemplo de Macroclases

Si el propósito del estudio no requiere el uso de Macroclases, entonces el mismo Macroclase ID puede ser utilizado para todos los ROIs (ej. Macroclase ID = 1) y las Macroclases serán ignoradas en el proceso de clasificación.

3.2.5. Algoritmos de clasificación¶

Las firmas espectrales (características espectrales) de las clases de cobertura de referencia son calculadas considerando los valores de los pixeles de cada ROI que tengan el mismo Clase ID (o Macroclase ID). Por lo tanto, el algoritmo de clasificación, clasifica la imagen completa comparando las características de cada pixel con las características espectrales de las clases de referencia. SCP implementa los siguientes algoritmos de clasificación.

3.2.5.1. Distancia mínima¶

El algoritmo Distancia Mínima calcula la distancia Euclídea \(d(x, y)\) entre las firmas espectrales de los pixeles de la imagen y las firmas espectrales de entrenamiento, de acuerdo a la siguiente ecuación:

donde:

\(x\) = vector de firma espectral de un pixel de la imagen;

\(y\) = vector de firma espectral del área de entrenamiento;

\(n\) = número de bandas de la imagen.

Por lo tanto, la distancia es calculada para cada pixel en la imagen, asignando la clase de la firma espectral más cercana de acuerdo a la siguiente función discriminante (adaptado de Richards and Jia, 2006):

donde:

\(C_k\) = clase de cobertura \(k\);

\(y_k\) = firma espectral de la clase \(k\);

\(y_j\) = firma espectral de la clase \(j\).

Es posible definir un umbral \(T_i\) para excluir de la clasificación los pixeles bajo este valor:

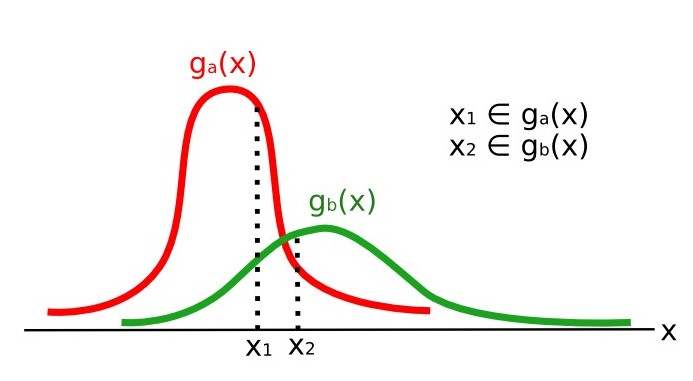

3.2.5.2. Máxima Probabilidad¶

El algoritmo “Máxima Probabilidad” calcula las distribuciones de probabilidad para las clases, relacionado al teorema de Bayes, estimando si un pixel pertenece a una clase de cobertura. En particular, las probabilidades de distribución de las clases son asumidas de la forma de modelos normales multivariados (Richards & Jia, 2006). Para utilizar este algoritmo, se requiere un número lo suficientemente alto de pixeles para cada área de entrenamiento, lo cual permite el cálculo de la matriz de covarianza. La función discriminante, descrita por Richards and Jia (2006), se calcula para cada pixel como:

donde:

\(C_k\) = clase de cobertura \(k\);

\(x\) = vector de firma espectral de un pixel de la imagen;

\(p(C_k)\) = probabilidad de que la clase correcta sea \(C_k\);

\(| \Sigma_{k} |\) = determinante de la matriz de covarianzas de los datos en la clase \(C_k\);

\(\Sigma_{k}^{-1}\) = inversa de la matriz de covarianzas;

\(y_k\) = vector de firma espectral de la clase \(k\).

Por consiguiente:

Ejemplo de Máxima Probabilidad

Adicionalmente, es posible definir un umbral de la función discriminante para excluir de la clasificación los pixeles bajo este valor. Considerando un umbral \(T_i\) , la condición de la clasificación resulta:

Máxima probabilidad es uno de los algoritmos de clasificación supervisada más comunes, sin embargo el proceso de clasificación puede ser más lento que Distancia mínima.

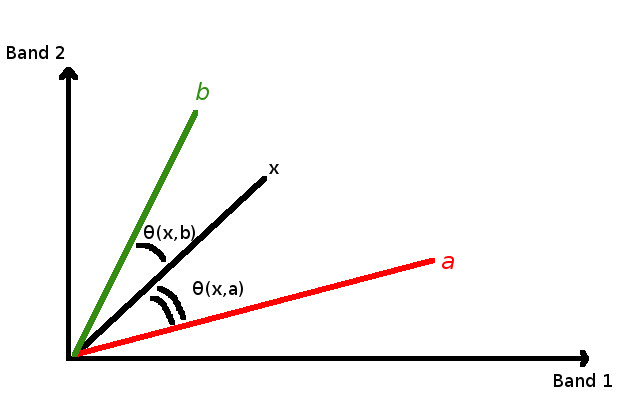

3.2.5.3. Mapeo del Angulo Espectral¶

El Mapeo de Ángulo Espectral calcula el ángulo espectral entre las firmas espectrales de los pixeles de la imagen y las firmas espectrales de entrenamiento. El ángulo espectral \(\theta\) es definido como (Kruse et al., 1993):

Donde:

\(x\) = vector de firma espectral de un pixel de la imagen;

\(y\) = vector de firma espectral del área de entrenamiento;

\(n\) = número de bandas de la imagen.

Por lo tanto un pixel pertenece a la clase teniendo el ángulo inferior, que es:

donde:

\(C_k\) = clase de cobertura \(k\);

\(y_k\) = firma espectral de la clase \(k\);

\(y_j\) = firma espectral de la clase \(j\).

Ejemplo de Mapeo de Ángulo Espectral

Para excluir de la clasificación los pixeles bajo este valor, es posible definir un umbral \(T_i\):

El Mapeo de Ángulo Espectral es ampliamente utilizado, especialmente con imágenes hiperespectrales.

3.2.5.4. Clasificación de Paralelepípedo¶

La clasificación por paralelepípedos es un algoritmo que considera el rango de valores de cada banda, formando un paralelepípedo multidimensional que define la clase de cobertura. Un pixel es clasificado dentro de una clase, si sus valores están dentro del paralelepípedo correspondiente. Una de las mayores desventajas es que los pixeles cuyas firmas se superponen a dos o más paralelepípedos no pueden ser clasificados (Richards and Jia, 2006).

3.2.5.5. Land Cover Signature Classification¶

Clasificación por Firmas de Cobertura del Suelo está disponible en SCP (mira Land Cover Signature Classification). Esta clasificación permite la definición de umbrales espectrales para cada firma de entrada (un valor mínimo y un valor máximo para cada banda). Los umbrales de cada firma de entrenamiento definen la región espectral perteneciente a cada clase de cobertura del suelo.

Las firmas espectrales de los pixeles de la imagen son comparados con las firmas espectrales de entrenamiento; un pixel pertenece a la clase X si la firma espectral del pixel está completamente contenida en la región definida por la clase X. En caso de pixeles que coinciden dentro de regiones superpuestas o fuera de cualquier región espectral, es posible utilizar algoritmos de clasificación adicionales (ej. ref:minimum_distance_algorithm, Máxima Probabilidad, Mapeo del Angulo Espectral) considerando las características espectrales de la firma original.

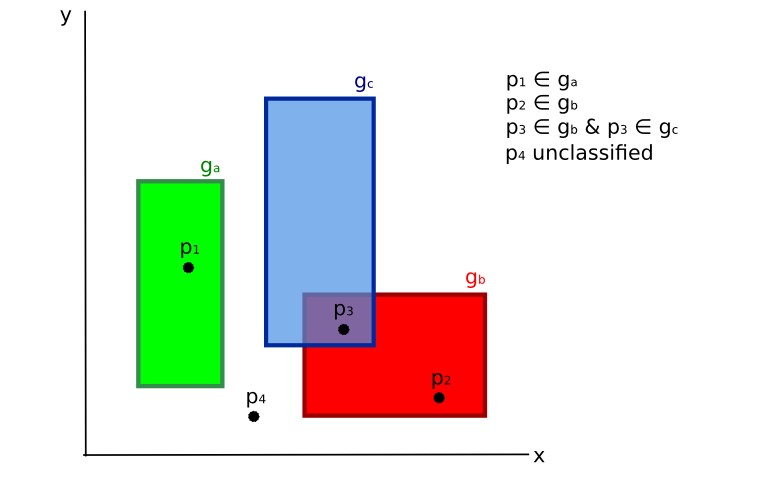

La siguiente figura ilustra un esquema de Clasificación por Firmas de Cobertura del Suelo para un caso simple de dos bandas espectrales \(x\) y \(y\). Las regiones espectrales definidas por el usuario definen tres clases (\(g_a\), \(g_b\), and \(g_c\)). El punto \(p_1\) pertenece a la clase \(g_a\) y el punto \(p_2\) pertenece a la clase \(g_b\). Sin embargo, el punto \(p_3\) está dentro de ambas regiones espectrales \(g_b\) y \(g_c\) (regiones superpuestas); en este caso, el punto \(p_3\) quedará sin clasificar o será clasificado según un algoritmo adicional de clasificación. El punto \(p_4\) está fuera de cualquier región espectra, por lo tanto quedará sin clasificar o será clasificado según un algoritmo adicional de clasificación. Dado que el punto \(p_4\) pertenece a la clase \(g_c\), la región espectral puede ser extendida para incluir el punto \(p_4\) .

Clasificación por Firmas de Cobertura del Suelo

Esto es similar a Clasificación de Paralelepípedo, con la excepción de que las regiones espectrales están definidas por el usuario y pueden ser asignadas independientemente para los límites mínimo y máximo. Es posible imaginar la región espectral como el conjunto de todas las firmas espectrales de los pixeles pertenecientes a una clase.

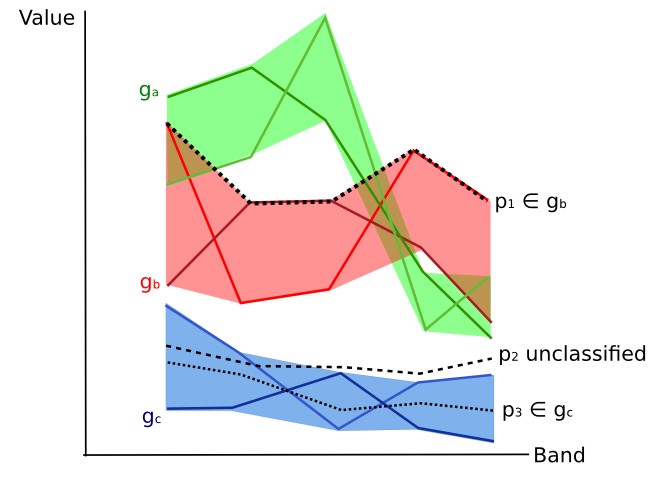

En la figura Gráfico de rangos espectrales se muestran los rangos espectrales de tres claes (\(g_a\), \(g_b\), y \(g_c\)); las líneas de colores dentro de los rangos (el área semi-transparente) representa las firmas espectrales de los pixeles que definieron los límites superior e inferior del rango respectivo. El pixel \(p_1\) (línea interpunteada) pertenece a la clase \(g_b\) debido a que su firma espectral está completamente dentro del rango de la clase \(g_b\) (en el límite superior). El pixel \(p_2\) (línea entrecortada) queda sin clasificar debido a que su firma espectral no cae completamente dentro de ningún rango. El pixel \(p_3\) (línea interpuntada) pertenece a la clase \(g_a\).

Gráfico de rangos espectrales

Es importante notar que estos umbrales espectrales pueden ser aplicados a cualquier forma espectral, independientemente de sus características espectrales. Esta función puede ser muy útil para separar firmas espectrales que difieren solamente en una banda, definiendo umbrales que incluyen o excluyen firmas específicas. De hecho, las clases se separan correctamente si sus rangos espectrales difieren en al menos una banda. Por supuesto, incluso si las regiones espectrales se superponen, es posible que ningún pixel caiga dentro del área superpuesta y sea clasificado incorrectamente. El límite superior o inferior de un rango no implica la existencia en la imagen de una firma espectral que tenga valores de rango mínimo o máximo para todas las bandas (Por ejemplo el pixel \(p_1\) de la figura Gráfico de rangos espectrales podría no existir).

Uno de los principales beneficios de la Clasificación por Firmas de Cobertura del Suelo es que es posible seleccionar pixeles e incluir su firma en un rango espectral. Por lo tanto, la clasificación debería ser la representación directa de las clases esperadas para cada cada firma espectral. Esto es muy útil para la clasificación de una única clase de cobertura del suelo (definida por umbrales espectrales específicos), y dejar sin clasificar el resto de la imagen que no sea de interés para el propósito de la clasificación.

3.2.5.6. Ráster de Algoritmo¶

Un ráster de algoritmo representa la “distancia” (según la definición del algoritmo de clasificación) de un pixel de la imagen a una firma espectral específica.

En general, se genera un ráster de algoritmo por cada firma espectral utilizada como entrenamiento. El valor de cada pixel es el resultado del cálculo del algoritmo para una firma espectral definida. Por lo tanto, un pixel pertenece a la class X si el valor del ráster de algoritmo correspondiente a la class X es el menor en el caso de Distancia mínima o Mapeo del Angulo Espectral, o el mayor en el caso de Máxima Probabilidad.

Para una clasificación dada, la combinación de rásters de algoritmo puede ser generada para crear un raster con las menores “distancias” (es decir, los pixeles tienen el valor del ráster de algoritmo correspondiente a la clase a la que pertenecen en la clasificación). Por lo tanto, este raster puede ser útil para identificar pixeles que requieren la recolección de más firmas espectrales similares (ver Clasificación preliminar).

3.2.6. Distancia Espectral¶

Es útil valorar la distancia espectral (o separabilidad) entre firmas de entrenamiento o pixeles para evaluar si diferentes clases que son muy similares entre sí podrían causar errores de clasificación. El :guilabel:`SCP`implementa los siguientes algoritmos para evaluar la similitud de firmas espectrales.

3.2.6.1. Jeffries-Matusita Distance¶

La distancia de Jeffries-Matusita calcula la separabilidad de un par de distribuciones de probabilidad. Esto puede tener significado particularmente para evaluar los resultados de clasificaciones Máxima Probabilidad.

La distancia Jeffries-Matusita \(J_{xy}\) se calcula como (Richards and Jia, 2006):

donde:

donde:

\(x\) = primer vector de firma espectral;

\(y\) = segundo vector de firma espectral;

\(\Sigma_{x}\) = matriz de covarianza de la muestra \(x\);

\(\Sigma_{y}\) = matriz de covarianza de la muestra \(y\);

La distancia Jeffries-Matusita es asintótica a 2 cuando las firmas son completamente diferentes, y tiende a 0 cuando las firmas son idénticas.

3.2.6.2. Angulo Espectral¶

El Ángulo Espectral es el más apropiado para evaluar los resultados de Mapeo del Angulo Espectral . El ángulo espectral \(\theta\) es definido como (Kruse et al., 1993):

Donde:

\(x\) = vector de firma espectral de un pixel de la imagen;

\(y\) = vector de firma espectral del área de entrenamiento;

\(n\) = número de bandas de la imagen.

El ángulo espectral varía de 0 cuando las firmas son idénticas a 90 cuando las firmas son completamente diferentes.

3.2.6.3. Distancia Euclidiana¶

La Distancia Euclidiana es particularmente útil para la evaluación de los resultados de la clasificación Distancia mínima. De hecho, la distancia es definida como:

donde:

\(x\) = primer vector de firma espectral;

\(y\) = segundo vector de firma espectral;

\(n\) = número de bandas de la imagen.

La Distancia Euclidiana es 0 cuando las firmas son idénticas y se incrementa según aumenta la distancia espectral entre las firmas.

3.2.6.4. Similaridad de Bray-Curtis¶

La Similaridad de Bray-Curtis Similarity es un estadístico usado para evaluar la relación entre dos muestras (leer). Es útil en general para evaluar la similaridad de firmas espectrales. La Similaridad de Bray-Curtis \(S(x, y)\) se calcula como:

donde:

\(x\) = primer vector de firma espectral;

\(y\) = segundo vector de firma espectral;

\(n\) = número de bandas de la imagen.

La Distancia de Bray-Curtis se calcula como porcentaje y varía de 0 cuando las firmas son completamente diferentes a 100 cuando las firmas son idénticas.

3.2.7. Resultado de la Clasificación¶

El resultado del proceso de clasificación es un raster (ver un resultado de clasificación de Landsat en la Figura Clasificación de Landsat), donde los valores de los pixeles corresponden a los Clase ID y cada color representa una clase de cobertura del suelo.

Clasificación de Landsat

Datos onbtenidos de U.S. Geological Survey

Un cierto número de errores pueden ocurrir durante la clasificación de cobertura del suelo (ej. algunos pixeles pueden haber sido asignados erróneamente a una clase de cobertura), debido a la similaridad espectral de las clases o a una definición incorrecta de las clases durante la recolección de ROIs.

3.2.8. Evaluación De la Exactitud¶

Luego del proceso de clasificación, es útil evaluar la exactitud de una clasificación de cobertura del suelo para identificar y medir los errores del mapa. Usualmente se realiza una evaluación de exactitud a través del cálculo de una matriz de errores, la cual consiste en una tabla que compara la información del mapa resultante de la clasificación con un conjunto de datos de referencia (ground truth) (Congalton and Green, 2009).

La siguiente tabla es un esquema de Matriz de Errores, donde k es el número de clases identificadas en la clasificación de cobertura del suelo, y n es el número total de unidades de muestreo recolectadas. Los números en la diagonal major (aii) representan el número de muestras correctamente identificadas, mientras que los otros números son errores de clasificación.

Esquema de Matriz de Errores

Referencia 1 |

Referencia 2 |

… | Referencia k |

Total | |

|---|---|---|---|---|---|

Clase 1 |

\(a_{11}\) | \(a_{12}\) | … | \(a_{1k}\) | \(a_{1+}\) |

Clase 2 |

\(a_{21}\) | \(a_{22}\) | … | \(a_{2k}\) | \(a_{2+}\) |

| … | … | … | … | … | … |

Clase k |

\(a_{k1}\) | \(a_{k2}\) | … | \(a_{kk}\) | \(a_{k+}\) |

| Total | \(a_{+1}\) | \(a_{+2}\) | … | \(a_{+k}\) | \(n\) |

Por lo tanto es posible calcular la precisión global como el ratio entre el número de muestras clasificadas correctamente (la suma de la diagonal mayor) y el número total de unidades n (Congalton and Green, 2009).

Para mayor información, la siguiente documentación se encuentra disponible de manera libre: Landsat 7 Science Data User’s Handbook, Remote Sensing Note , o Wikipedia.

3.3. Conversión de la imagen a Reflectancia¶

Este capítulo provee información sobre la conversión a reflectancia implementada en SCP.

3.3.1. Radiancia en el sensor.¶

Radiancia es el “Flujo de energía (principalmente energía irradiante o incidente) por ángulo sólido que abandona una unidad de área de una superficie en una dirección dada”, “Radiancia es lo que mide el sensor y depende en cierta medida de la reflectancia” (NASA, 2011, p. 47).

Imágenes como las de Landsat o Sentinel-2 están compuestas de diferentes bandas y un archivo de metadatos que contiene la información requerida para la reflectancia.

Las imágenes de Landsat son provistas en radiancia, escaladas previamente al resultado. Para imágenes Landsat, la Radiancia espectral en el sensor (\(L_{\lambda}\), medida en [vatios/(metro cuadrado * ster * \(\mu m\))]) está dada por (https://landsat.usgs.gov/Landsat8_Using_Product.php):

donde:

\(M_{L}\) = Factor multiplicativo de reescalamiento específico de la banda, proveniente de los metadatos (RADIANCE_MULT_BAND_x, donde x es el número de banda)

\(A_{L}\) = Factor aditivo de reescalamiento específico de la banda, proveniente de los metadatos (RADIANCE_MULT_BAND_x, donde x es el número de banda)

\(Q_{cal}\) = Valores de pixel discretizados y calibrados del producto estandar (valores digitales DN)

Imágenes Sentinel-2 (Level-1C) se proveen directamente en Reflectancia en el Techo de la Atmósfera (TOA), escaladas previamente al resultado (ESA, 2015).

3.3.2. Reflectancia en el Techo de la Atmósfera (TOA)¶

Es posible convertir imágenes con valores de radiancia a valores de Reflectancia en el Techo de la Atmósfera (TOA), la cual combina la reflectancia de la superficie y la reflectancia atmosférica, para reducir la variabilidad inter-imagen a través de una normalización de la irradiancia solar. Esta reflectancia TOA (\(\rho_{p}\)), la cual es el ratio de la energía reflejada con respecto al total de la energía incidente (NASA, 2011), puede ser calculada como:

donde:

\(L_{\lambda}\) = Radiancia espectral en el sensor (Radiancia en el satélite)

\(d\) = Distancia Tierra-Sol en Unidades Astronómicas (la cual se encuentra en el archivo de metadatos de las imágenes Landsat 8, y un archivo de excel en http://landsathandbook.gsfc.nasa.gov/excel_docs/d.xls)

\(ESUN_{\lambda}\) = Irradiancia Media Solar exo-atmosférica

\(\theta_{s}\) = Angulo zenital solar en grados, el cual es equivalente a: \(\theta_{s}\) = 90° - \(\theta_{e}\) donde \(\theta_{e}\) es la elevación solar

Es importante notar que para las imágenes de Landsat 8 se proveen factores de reescalamiento para cada banda que permiten la conversión directa de valores digitales DN a Reflectancia TOA.

Las imágenes Sentinel-2 se distribuyen ya con valores de reflectancia TOA escalados, los cuales pueden ser convertidos a reflectancia TOA con un cálculo simple utilizando el Valor de Discretización provisto en los metadatos (ver https://sentinel.esa.int/documents/247904/349490/S2_MSI_Product_Specification.pdf).

3.3.3. Reflectancia de la Superficie¶

Los efectos de la atmósfera (i.e. la perturbación en los valores de reflectancia que varía con la longitud de onda) debe ser considerada para medir la reflectancia en la superficie.

La reflectancia de la superficie (\(\rho\)), tal como lo describe Moran et al. (1992), es:

donde:

\(L_{p}\) es el efecto bruma, en inglés path radiance

\(T_{v}\) es la transmitancia de la atmósfera en la dirección de visión

\(T_{z}\) es la transmitancia atmosférica en la dirección de iluminación

\(E_{down}\) is la irradiancia difusa descendiente

Por lo tanto, necesitamos varias medidas atmosféricas para calcular \(\rho\) (correcciones basadas en medidas físicas). Alternativamente, es posible utilizar técnicas basadas en imágen para el cálculo de esos parámetros sin la necesidad de medidas in-situ durante la adquisición de la imagen. Vale la pena mencionar que el Producto de Alto Nivel Landsat Reflectancia de Superficie para Landsat 8 está disponible (para más información leer http://landsat.usgs.gov/CDR_LSR.php).

3.3.4. Corrección DOS1¶

El Dark Object Substrction (DOS) o substracción de objeto oscuro es una familia de correcciones atmosféricas basadas en imagen. Chavez (1996) explica que “la suposición básica es que en la imagen algunos píxeles están completamente en sombra, y sus radiancias recibidas en el satélite se deben a la dispersión atmosférica (efecto bruma). Esta suposición es combinada con el hecho de que muy pocos elementos en la superficie de la Tierra tienen un color negro absoluto, por lo tanto, una reflectancia asumida de uno por ciento es mejor que un cero por ciento”. Es importante mencionar que la exactitud de las técnicas basadas en imagen es generalmente menor que las correcciones basadas en medidas físicas, pero son muy útiles cuando no están disponibles mediciones atmosféricas que puedan mejorar la estimación de la reflectancia de la superficie terrestre. El efecto bruma es dado por (Sobrino, et al., 2004):

donde:

\(L_{min}\) = “radiancia que corresponde a un valor digital para el cual la suma de todos los píxeles con valores digitales menores o iguales a este valor es igual al 0.01% de todos los píxeles de la imagen considerada” Sobrino, et al., 2004, p. 437), por lo tanto, la radiancia obtenida con ese valor de conteo digital (\(DN_{min}\))

\(L_{DO1\%}\) = radiancia del objeto oscuro, con un valor asumido de reflectancia de 0.01

En particular para imágenes Landsat:

Las imágenes Sentinel-2 son convertidas a radiancia antes del cálculo DOS1.

La Radiancia de Objeto Oscuro es dada por (Sobrino, et al., 2004):

Por lo tanto, el efecto bruma es:

Existen varias técnicas DOS (ej. DOS1, DOS2, DOS3, DOS4), basadas en diferentes asunciones acerca de \(T_{v}\), \(T_{z}\), y \(E_{down}\) . La técnica más simple es la DOS1, donde se hacen las siguientes suposiciones (Moran et al., 1992):

- \(T_{v}\) = 1

- \(T_{z}\) = 1

- \(E_{down}\) = 0

Por lo tanto, el efecto bruma es:

Y la reflectancia de la superficie terrestre resultante está dada por:

Los valores ESUN [W /(m2 * \(\mu m\))] para sensores Landsat se encuentran en la siguiente tabla.

Valores ESUN para bandas Landsat

Banda |

Landsat 1 MSS |

Landsat 2 MSS |

Landsat 3 MSS |

Landsat 4 TM |

Landsat 5 TM* | Landsat 7 ETM+** |

|---|---|---|---|---|---|---|

| 1 | 1983 | 1983 | 1970 | |||

| 2 | 1795 | 1796 | 1842 | |||

| 3 | 1539 | 1536 | 1547 | |||

| 4 | 1823 | 1829 | 1839 | 1028 | 1031 | 1044 |

| 5 | 1559 | 1539 | 1555 | 219.8 | 220 | 225.7 |

| 6 | 1276 | 1268 | 1291 | |||

| 7 | 880.1 | 886.6 | 887.9 | 83.49 | 83.44 | 82.06 |

| 8 | 1369 |

* de Chander, Markham, & Helder (2009)

** de http://landsathandbook.gsfc.nasa.gov/data_prod/prog_sect11_3.html

Para Landsat 8, \(ESUN\) puede ser calculado como (from http://grass.osgeo.org/grass65/manuals/i.landsat.toar.html):

donde RADIANCE_MAXIMUM y REFLECTANCE_MAXIMUM son provistas en los metadatos de la imagen.

Los valores de ESUN [W /(m2 * \(\mu m\))] para el sensor Sentinel-2 (provistos en los metadatos de la imagen) se muestran en la siguiente tabla.

valores de ESUN para bandas de Sentinel-2

Banda |

Sentinel-2 |

|---|---|

| 1 | 1913.57 |

| 2 | 1941.63 |

| 3 | 1822.61 |

| 4 | 1512.79 |

| 5 | 1425.56 |

| 6 | 1288.32 |

| 7 | 1163.19 |

| 8 | 1036.39 |

| 8A | 955.19 |

| 9 | 813.04 |

| 10 | 367.15 |

| 11 | 245.59 |

| 12 | 85.25 |

Los valores de ESUN [W /(m2 * \(\mu m\))] para el sensor ASTER se muestran en la siguiente tabla (de Finn, et al., 2012).

Valores de ESUN para bandas ASTER

Banda |

ASTER |

|---|---|

| 1 | 1848 |

| 2 | 1549 |

| 3 | 1114 |

| 4 | 225.4 |

| 5 | 86.63 |

| 6 | 81.85 |

| 7 | 74.85 |

| 8 | 66.49 |

| 9 | 59.85 |

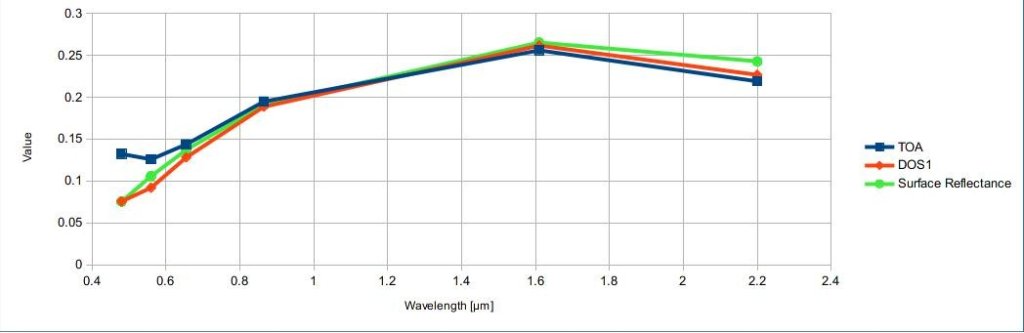

Un ejemplo de comparación de valores de Reflectancia TOA, Reflectancia corregida con DOS1 y Producto de Alto Nivel Landsat Reflectancia de Superficie (datos de referencia) se puede ver en la figura Firmas espectrales de un píxel de superficie construida.

Firmas espectrales de un píxel de superficie construida

Comparación de valores de Reflectancia TOA, Reflectancia corregida con DOS1 y Producto de Alto Nivel Landsat Reflectancia de Superficie

3.4. Conversión a temperatura¶

Este capítulo proporciona información básica sobre la conversión a Temperatura de Brillo en el Satélite implementada en :guilabel:`SCP`y la estimación de la Temperatura Superficial del Suelo.

3.4.1. Conversión a Temperatura de Brillo en el Satélite¶

Para las bandas termales, la conversión de valores digitales DN a Temperatura de Brillo en el satélite es dada por (from https://landsat.usgs.gov/Landsat8_Using_Product.php):

donde:

\(K_{1}\) = constante de conversión térmica específica de la banda (en vatios /metro cuadrado * ster * \(\mu m\))

\(K_{2}\) = Constante de conversión térmica específica de la banda (en grados kelvin)

y \(L_{\lambda}\) es la radiancia espectral en el sensor, medida en vatios/(metro cuadrado * ster * \(\mu m\)).

Las cosntantes \(K_{1}\) y \(K_{2}\) para sensores Landsat son proporcionadas en la siguiente tabla.

Constantes de conversión térmica para Landsat

Constante |

Landsat 4* | Landsat 5* | Landsat 7** |

|---|---|---|---|

| \(K_{1}\) | 671.62 | 607.76 | 666.09 |

| \(K_{2}\) | 1284.30 | 1260.56 | 1282.71 |

* de Chander & Markham (2003)

** de NASA (2011)

Para Landsat 8, los valores de \(K_{1}\) y \(K_{2}\) son proprocionadas en el archivo de metadatos de la imagen.

\(K_{1}\) y \(K_{2}\) son calculadas como (Jimenez-Munoz & Sobrino, 2010):

donde (Mohr, Newell, & Taylor, 2015):

\(c_{1}\) = Primera constante de radiación = \(1.191 * 10^{-16} W m^{2} sr^{-1}\)

\(c_{2}\) = segunda constante de radiación = \(1.4388 * 10^{-2} m K\)

Por lo tanto, \(K_{1}\) y \(K_{2}\) para bandas ASTER se proporcionan en la siguiente tabla.

Constantes de conversión térmica para ASTER

Constante |

Banda 10 |

Banda 11 |

Banda 12 |

Banda 13 |

Banda 14 |

|---|---|---|---|---|---|

| \(K_{1}\) | \(3.024 * 10^{3}\) | \(2.460 * 10^{3}\) | \(1.909 * 10^{3}\) | \(8.900 * 10^{2}\) | \(6.464 * 10^{2}\) |

| \(K_{2}\) | \(1.733 * 10^{3}\) | \(1.663 * 10^{3}\) | \(1.581 * 10^{3}\) | \(1.357 * 10^{3}\) | \(1.273 * 10^{3}\) |

3.4.2. Estimación de la Temperatura de Superficie del Suelo¶

Varios estudios han descrito la estimación de la Temperatura de Superficie del Suelo. Ésta puede ser calculada a partir de la Temperatura de Brillo en el Satélite \(T_{B}\) como (Weng, et al. 2004):

donde:

\(\lambda\) = longitud de onda de la radiancia emitida

- \(c_{2} = h * c / s = 1.4388 * 10^{-2}\) m K

\(h\) = Constante de Planck’s = \(6.626 * 10^{-34}\) J s

\(s\) = constante de Boltzmann = \(1.38 * 10^{-23}\) J/K

\(c\) = velocidad de la luz \(2.998 * 10^{8}\) m/s

Los valores de \(\lambda\) para las bandas térmicas de los satélites Landsat y ASTER pueden ser calculadas a partir de las tablas Satélite Landsat y Satélite ASTER.

Varios estudios han utilizado el NDVI para la estimación de la emisividad de la superficie (SObrino, et al., 2004); otros estudios han utilizado una clasificación de cobertura del suelo para la definición de la emisividad de cada clase (Weng, et al. 2004). Por ejemplo, los valores de emisividad (\(e\)) de varios tipos de cobertura del suelo se proporcionan en la siguiente tabla (de Mallick, et al. 2012).

Valores de emisividad

Superficie de la tierra |

Emisividad e |

|---|---|

Suelo |

0.928 |

Pasto |

0.982 |

Asfalto |

0.942 |

Concreto |

0.937 |

3.5. Referencias¶

- Chander, G. & Markham, B. 2003. Revised Landsat-5 TM radiometric calibration procedures and postcalibration dynamic ranges Geoscience and Remote Sensing, IEEE Transactions on, 41, 2674 - 2677

- Chavez, P. S. 1996. Image-Based Atmospheric Corrections - Revisited and Improved Photogrammetric Engineering and Remote Sensing, [Falls Church, Va.] American Society of Photogrammetry, 62, 1025-1036

- Congalton, R. and Green, K., 2009. Assessing the Accuracy of Remotely Sensed Data: Principles and Practices. Boca Raton, FL: CRC Press

- Didan, K.; Barreto Munoz, A.; Solano, R. & Huete, A. 2015. MODIS Vegetation Index User’s Guide. Collection 6, NASA

- ESA, 2015. Sentinel-2 User Handbook. Available at https://sentinel.esa.int/documents/247904/685211/Sentinel-2_User_Handbook

- Finn, M.P., Reed, M.D, and Yamamoto, K.H. 2012. A Straight Forward Guide for Processing Radiance and Reflectance for EO-1 ALI, Landsat 5 TM, Landsat 7 ETM+, and ASTER. Unpublished Report from USGS/Center of Excellence for Geospatial Information Science, 8 p, http://cegis.usgs.gov/soil_moisture/pdf/A%20Straight%20Forward%20guide%20for%20Processing%20Radiance%20and%20Reflectance_V_24Jul12.pdf

- Fisher, P. F. and Unwin, D. J., eds. 2005. Representing GIS. Chichester, England: John Wiley & Sons

- JARS, 1993. Remote Sensing Note. Japan Association on Remote Sensing. Available at http://www.jars1974.net/pdf/rsnote_e.html

- Jimenez-Munoz, J. C. & Sobrino, J. A. 2010. A Single-Channel Algorithm for Land-Surface Temperature Retrieval From ASTER Data IEEE Geoscience and Remote Sensing Letters, 7, 176-179

- Johnson, B. A., Tateishi, R. and Hoan, N. T., 2012. Satellite Image Pansharpening Using a Hybrid Approach for Object-Based Image Analysis ISPRS International Journal of Geo-Information, 1, 228. Available at http://www.mdpi.com/2220-9964/1/3/228)

- Kruse, F. A., et al., 1993. The Spectral Image Processing System (SIPS) - Interactive Visualization and Analysis of Imaging spectrometer. Data Remote Sensing of Environment

- Mallick, J.; Singh, C. K.; Shashtri, S.; Rahman, A. & Mukherjee, S. 2012. Land surface emissivity retrieval based on moisture index from LANDSAT TM satellite data over heterogeneous surfaces of Delhi city International Journal of Applied Earth Observation and Geoinformation, 19, 348 - 358

- Mohr, P. J.; Newell, D. B. & Taylor, B. N. 2015. CODATA Recommended Values of the Fundamental Physical Constants: 2014 National Institute of Standards and Technology, Committee on Data for Science and Technology

- Moran, M.; Jackson, R.; Slater, P. & Teillet, P. 1992. Evaluation of simplified procedures for retrieval of land surface reflectance factors from satellite sensor output Remote Sensing of Environment, 41, 169-184

- NASA (Ed.) 2011. Landsat 7 Science Data Users Handbook Landsat Project Science Office at NASA’s Goddard Space Flight Center in Greenbelt, 186 http://landsathandbook.gsfc.nasa.gov/pdfs/Landsat7_Handbook.pdf

- NASA, 2013. Landsat 7 Science Data User’s Handbook. Available at http://landsathandbook.gsfc.nasa.gov

- Ready, P. and Wintz, P., 1973. Information Extraction, SNR Improvement, and Data Compression in Multispectral Imagery. IEEE Transactions on Communications, 21, 1123-1131

- Richards, J. A. and Jia, X., 2006. Remote Sensing Digital Image Analysis: An Introduction. Berlin, Germany: Springer.

- Sobrino, J.; Jiménez-Muñoz, J. C. & Paolini, L. 2004. Land surface temperature retrieval from LANDSAT TM 5 Remote Sensing of Environment, Elsevier, 90, 434-440

- USGS, 2015. Advanced Spaceborne Thermal Emission and Reflection Radiometer (ASTER) Level 1 Precision Terrain Corrected Registered At-Sensor Radiance Product (AST_L1T). AST_L1T Product User’s Guide. USGS EROS Data Center.

- Vermote, E. F.; Roger, J. C. & Ray, J. P. 2015. MODIS Surface Reflectance User’s Guide. Collection 6, NASA

- Weng, Q.; Lu, D. & Schubring, J. 2004. Estimation of land surface temperature–vegetation abundance relationship for urban heat island studies. Remote Sensing of Environment, Elsevier Science Inc., Box 882 New York NY 10159 USA, 89, 467-483